2022年8月23日(火)から25日(木)の3日間にわたり開催となった、“CEDEC 2022”(コンピューターエンターテインメントデベロッパーズカンファレンス2022)。こちらの記事では、その2日目に行なわれたセッション“強化学習AIを活用してゲームデザインを!:「桃太郎電鉄~昭和 平成 令和も定番!~」「実況パワフルサッカー」”の内容をお届けしていく。

本セッションの講演者は、株式会社コナミデジタルエンタテインメントの岩倉宏介氏(技術開発部主査)、池畑望氏(第三制作部プログラマー)、宗政俊一氏(技術開発部プログラマー)の3名だ。

こちらのセッションでは、“強化学習AI”とはどういうもので、実際にゲーム開発の場面ではどんな挙動や活躍を見せるのか、非常に分かりやすい具体例と活用例によって紹介された。単純に状況に対応するだけではなく、そのさきにある最終的な“評価”を優先できる強化学習AIの果たす役割は、もはや重要ないちスタッフの立ち位置にも匹敵しているのだ。

強化学習AIは“価値”を得る手段を模索する

今回の講演では、まずは強化学習AIの基本的な仕組みを解説。続いて、強化学習AIを用いるとこのような面白いことが起こるという実例として、『桃太郎電鉄~昭和 平成 令和も定番!~』(以下、『桃鉄』)の開発段階での活用例と、ゲームが実際にユーザーの手元に届いて以降はどういった活躍ができるのかという、『実況パワフルサッカー』(以下、『パワサカ』)におけるバランス調整での活用例を紹介した。

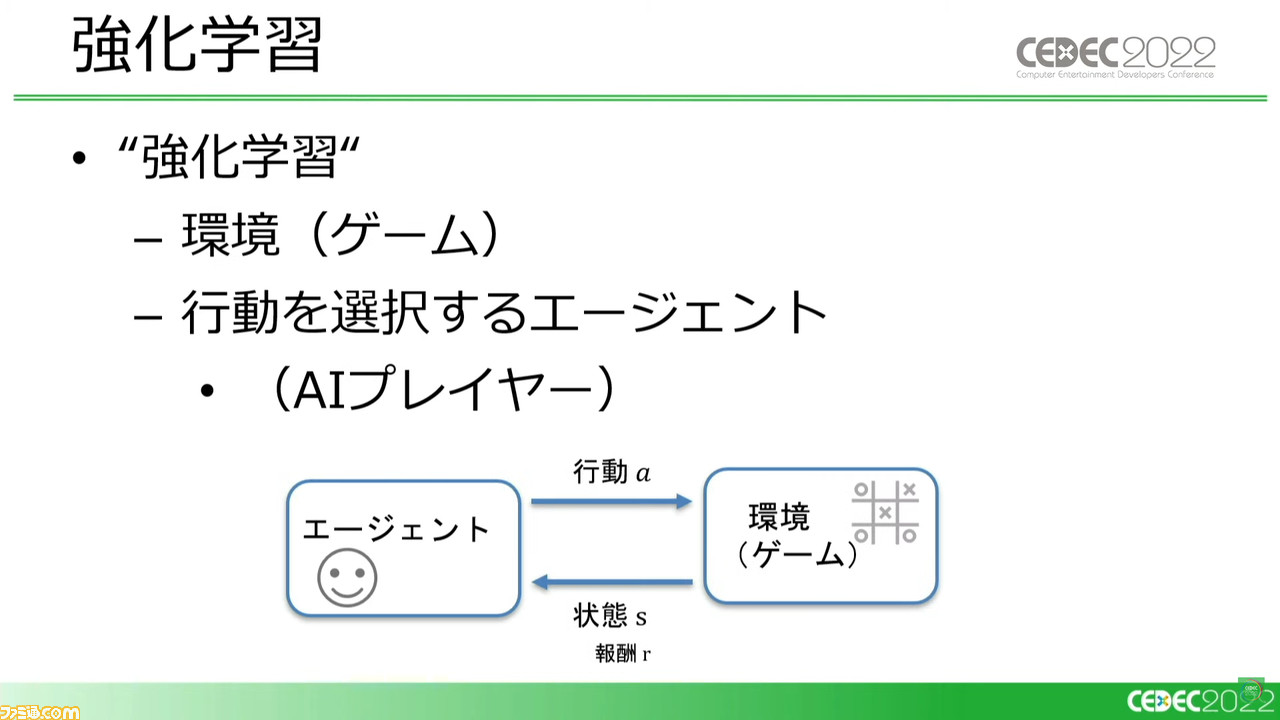

まず、そもそも“強化学習AI”とはなにか。AIはあらゆる事象を数値化して学習していくもので、強化学習AIはとくに“価値”を数値化し、最重視していく性質を持つ。まずは“いまの状態がどれくらい良いのか”という価値を、V値という具体的な数値に変えて学習する。

たとえばスゴロクゲームなら、ゴールに近いプレイヤーのほうが単純に有利に思えたり、遠くにいるプレイヤーのほうがじつはさきに上がれる可能性が高かったりと、そうした勘所は繰り返しプレイしていくうちに身につくものだ。AIもそれと同じく、各状況の価値を学習していく。

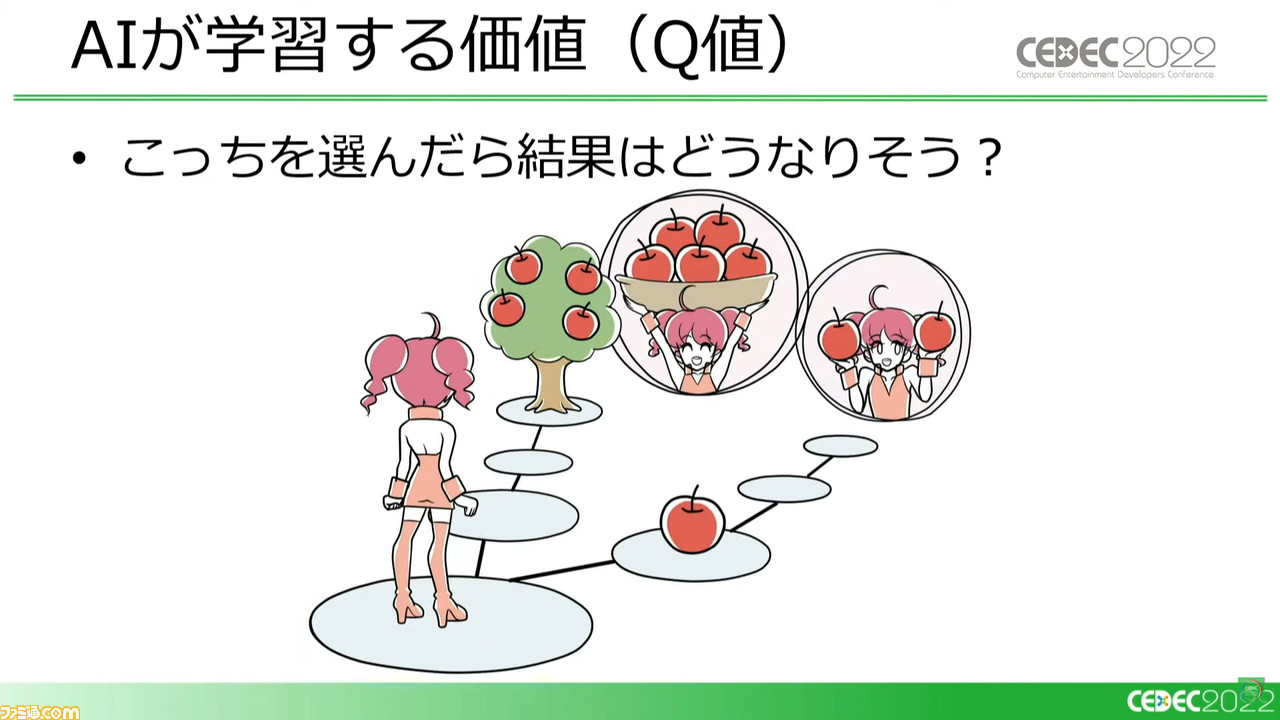

ゲームにはつねに選択肢がある。その選択肢も、目先の利益よりもゲームクリアー時にどんな利益があるのかを考えて選ばなくてはならない。強化学習AIも、どの選択肢でどれだけいい結果(価値)が最終的に得られそうか、という点を学習していく。

また、適切な選択肢を選んでいくだけでは、すべての価値が得られるわけではない。たとえば、下を見て歩いていれば足元に落ちているリンゴには気がつけるが、木の上になっているリンゴには気がつかないわけで、この場面なら上を見て歩いたほうが多くの価値を得られる。

強化学習AIはいろいろな行動パターンを試していき、どの行動が一番多くの報酬(価値)を得られるのかを学習していく。

ゲームにおける強化学習AIとはこのように、正しく価値を推測できるようにしつつ、より高い価値を得られる行動パターンを学習し獲得していくものとなっている。価値にあたるものはゲームによって異なり、勝利条件の達成や強いキャラクターの育成達成などさまざまだ。

『桃鉄』開発初期からAIがいたら? 貧乏神はここでも強敵だった

そんな強化学習AIが、ゲームの開発初期から現場にいてくれるとどのようなことが起こるのか。講演では引き続き、『桃鉄』開発現場におけるケースを紹介した。

『桃太郎電鉄~昭和 平成 令和も定番!~』は、2020年11月に発売された『桃太郎電鉄』シリーズ最新作。各プレイヤーが鉄道会社の社長となってサイコロを振って日本全国を駆け巡り、全国の物件を手に入れて総資産日本一を目指す、ボードゲーム形式のタイトルだ。

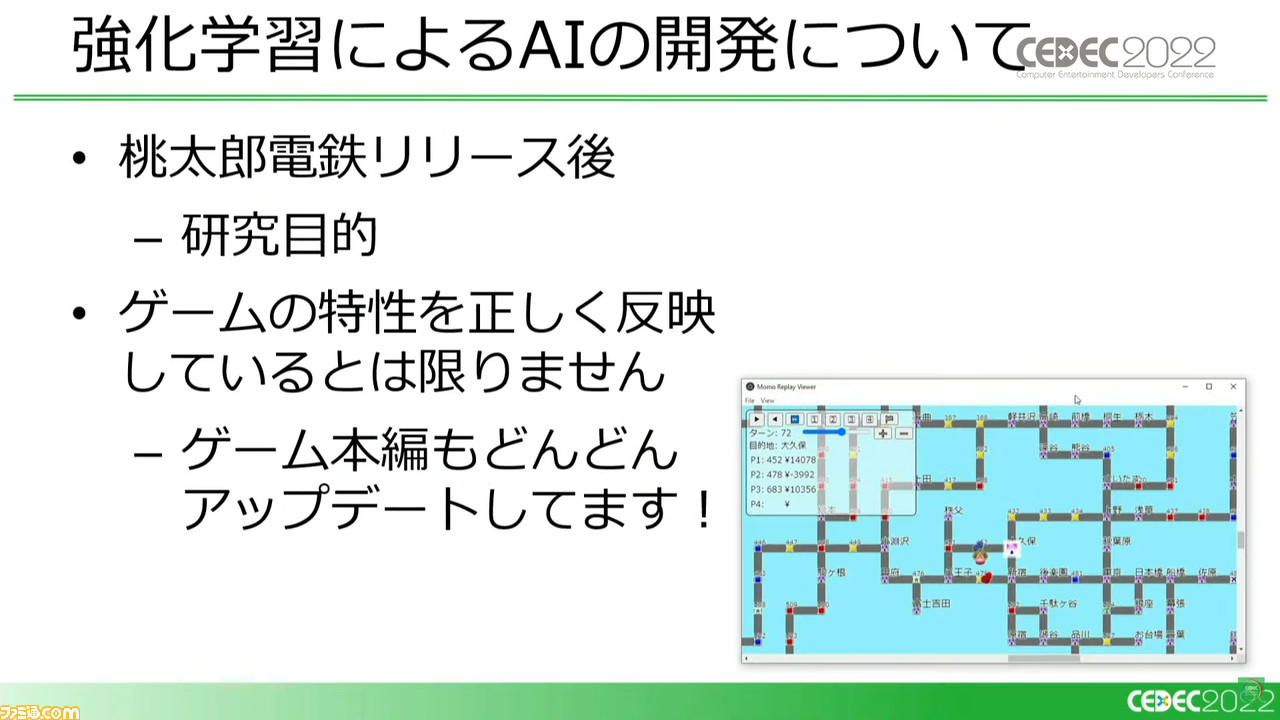

なお、今回の強化学習AIによる開発事例については、『桃鉄』リリース後に研究目的で取り組んだものとなっている。現在リリース済みの同作とは仕様面や戦略面などで異なる点もあり、またゲーム本編もアップデートを続けて変化している点には留意していただきたい。

ここで「リリース後の取り組みなのに、開発初期からの事例いうことになっているの?」と思われる人も多いだろう。じつはこのシミュレーター環境には、最初からリリース後の全データを入れたわけではなかった。

今回の事例では、シミュレーターは最初は北海道マップのみの単純な仕様のみ入った状態からスタートし、徐々にゲームの仕様を追加していった。開発初期からの段階を追うようなこの環境で、強化学習AIがどのようなふるまいを見せていったかが、非常に興味深かったというわけだ。

まずはミニ桃鉄とでも言うべき、機能を絞ったシンプルなシミュレーターを作成。複雑なシミュレーターだと学習に失敗した場合、ゲーム側と強化学習側のどちらに原因があるのかの究明が困難になると思われたためだ。

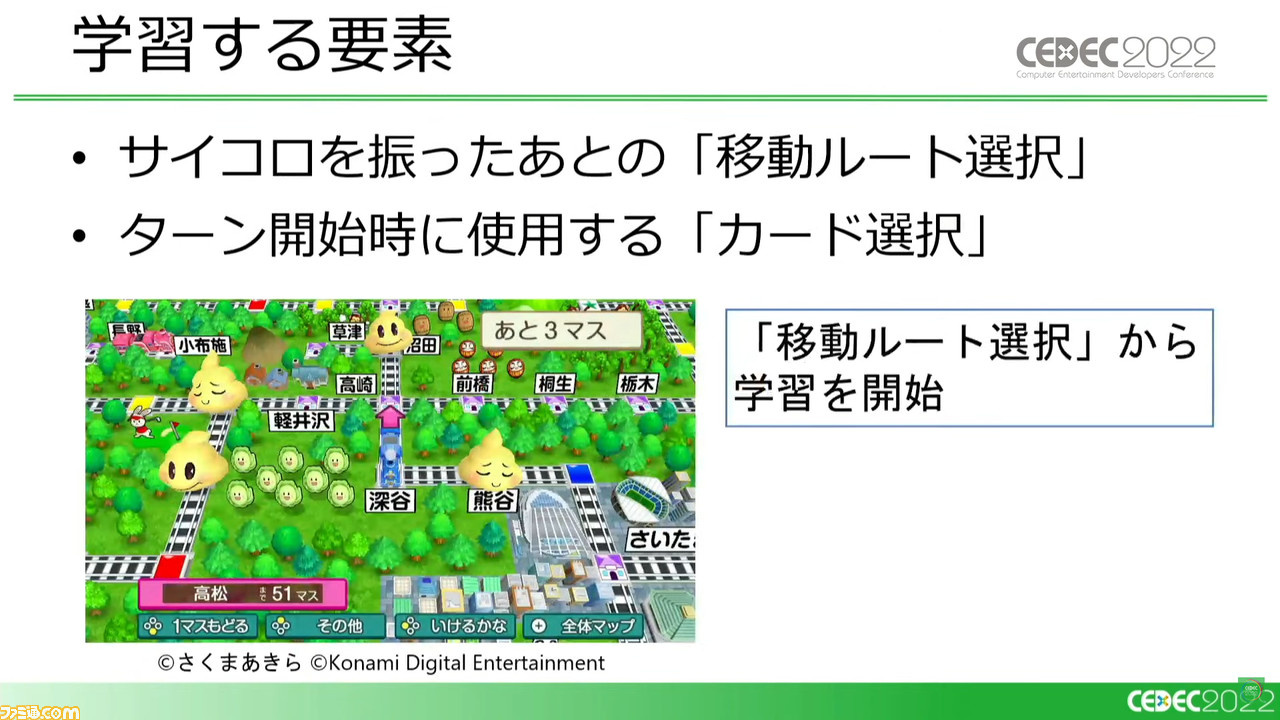

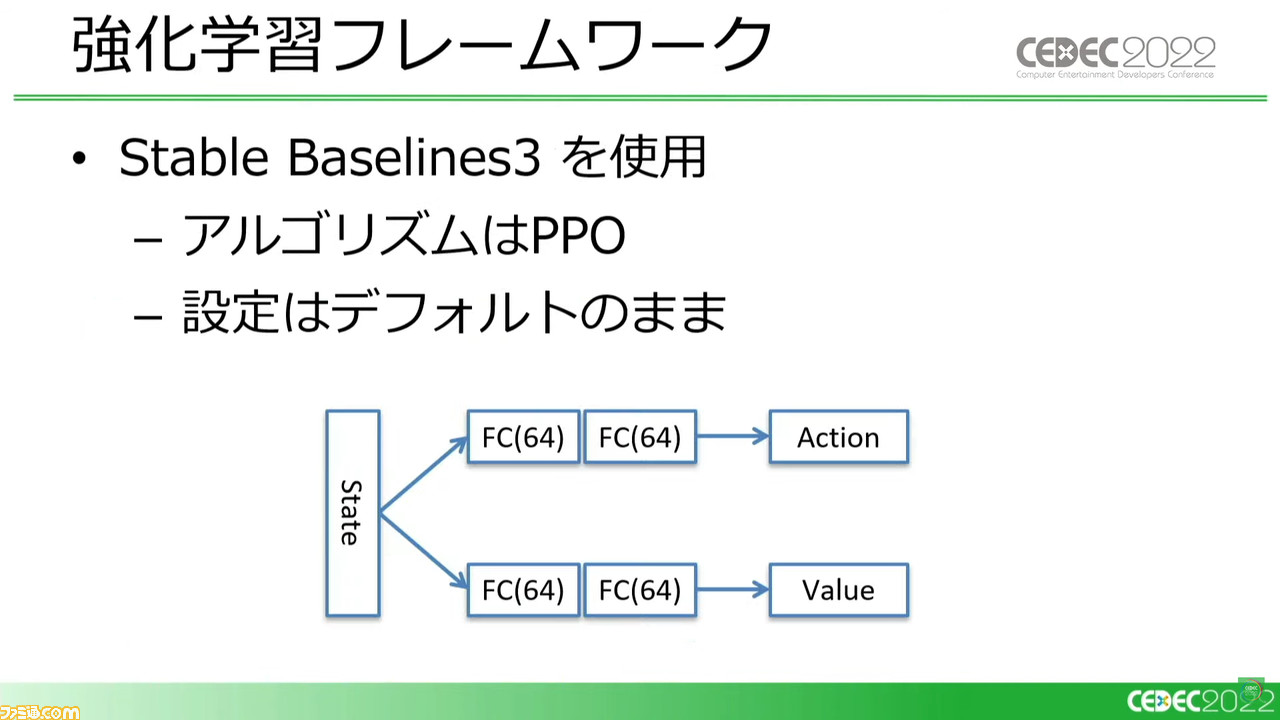

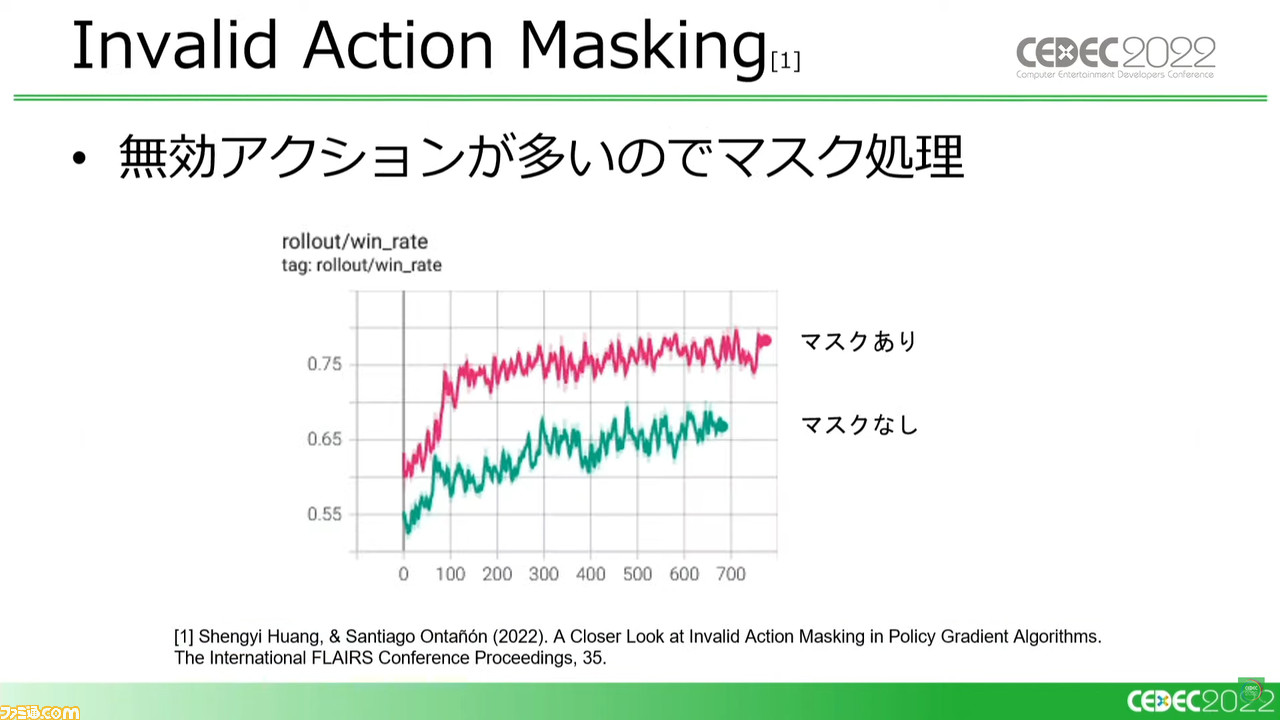

ゲーム中の判断要素もいろいろとあるが、まずは移動ルートの選択と、カードの選択のみを学習。実証実験ということで、手っ取り早く既存のフレームワークを規定値のままで使用していった。

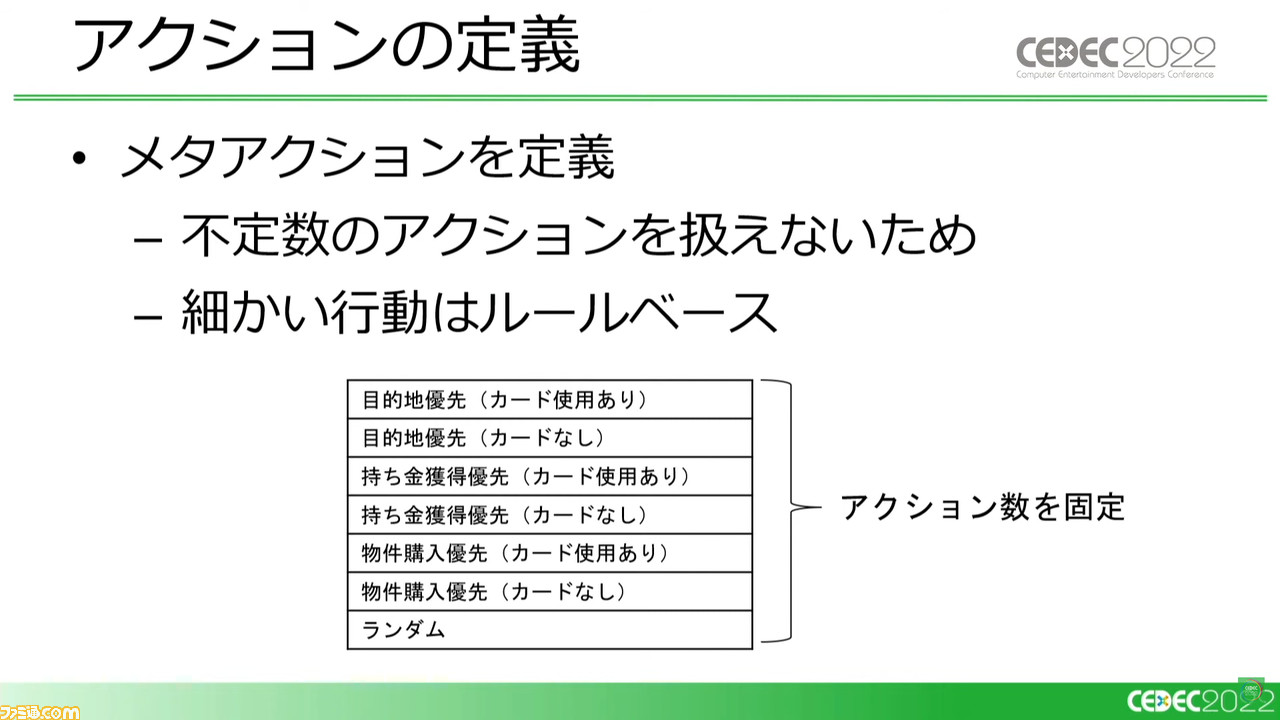

また、サイコロを振ってからのルート選択だけでもその選択肢は不定数となるため、あらかじめ“目的地を目指す”、“持ち金をプラス駅で増やす”、“物件を購入する”という3つのメタアクションに、サイコロの数を増やすカードを使うかどうかのパターンとランダムを加え、アクション数を定数とした。

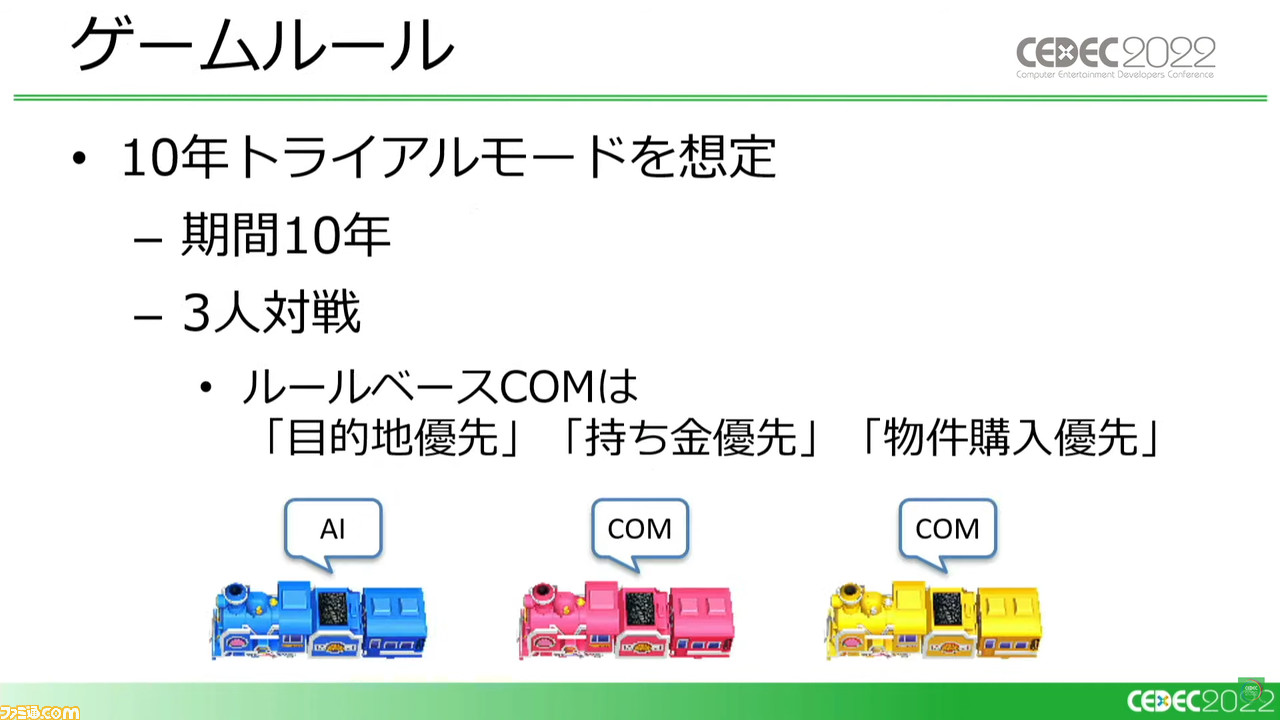

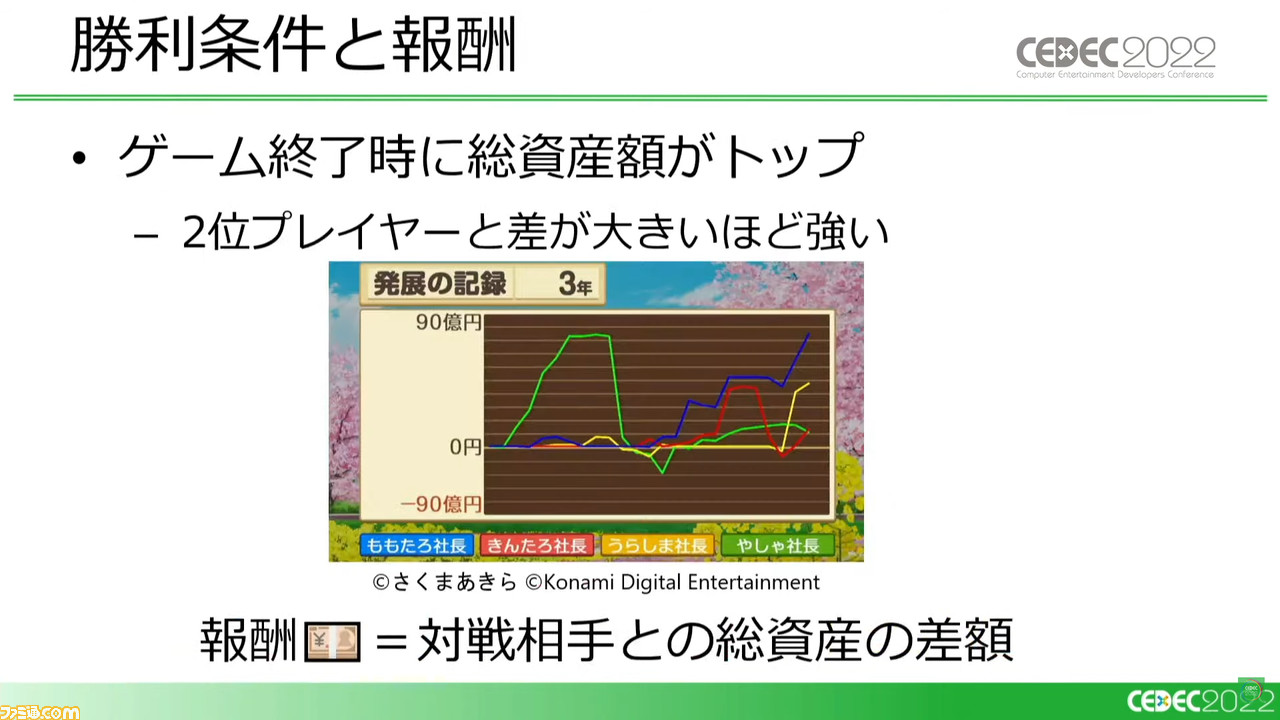

対戦相手にはルールベースで行動するCOMをふたり用意し、2位プレイヤーと差が大きいほど“強い”という、総資産の差額という価値(報酬)を定義する。

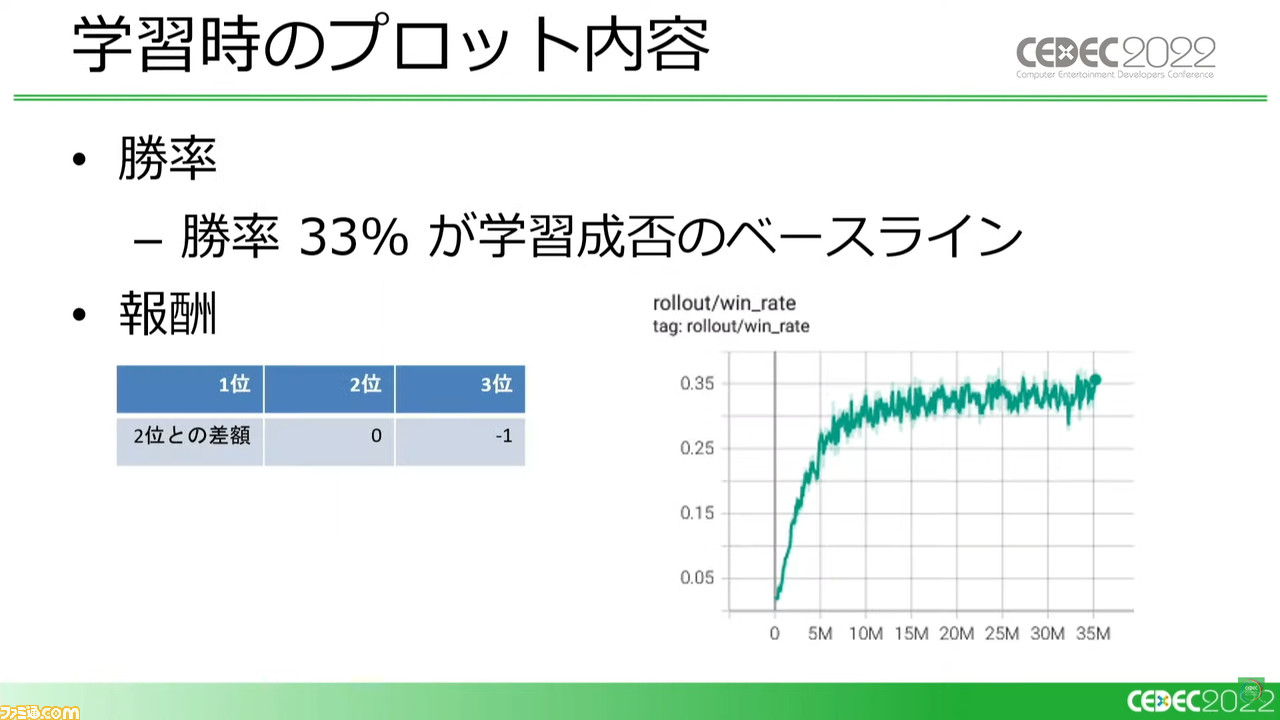

勝率33%が学習成否のベースラインとしたがそのままでは学習できないケースも出てきたため、2位、3位になった場合の報酬についても定数化し、1位になった場合の差額についてはこの定数に対して数値が大きくなりすぎるため、スケーリングして落とし込んだ。

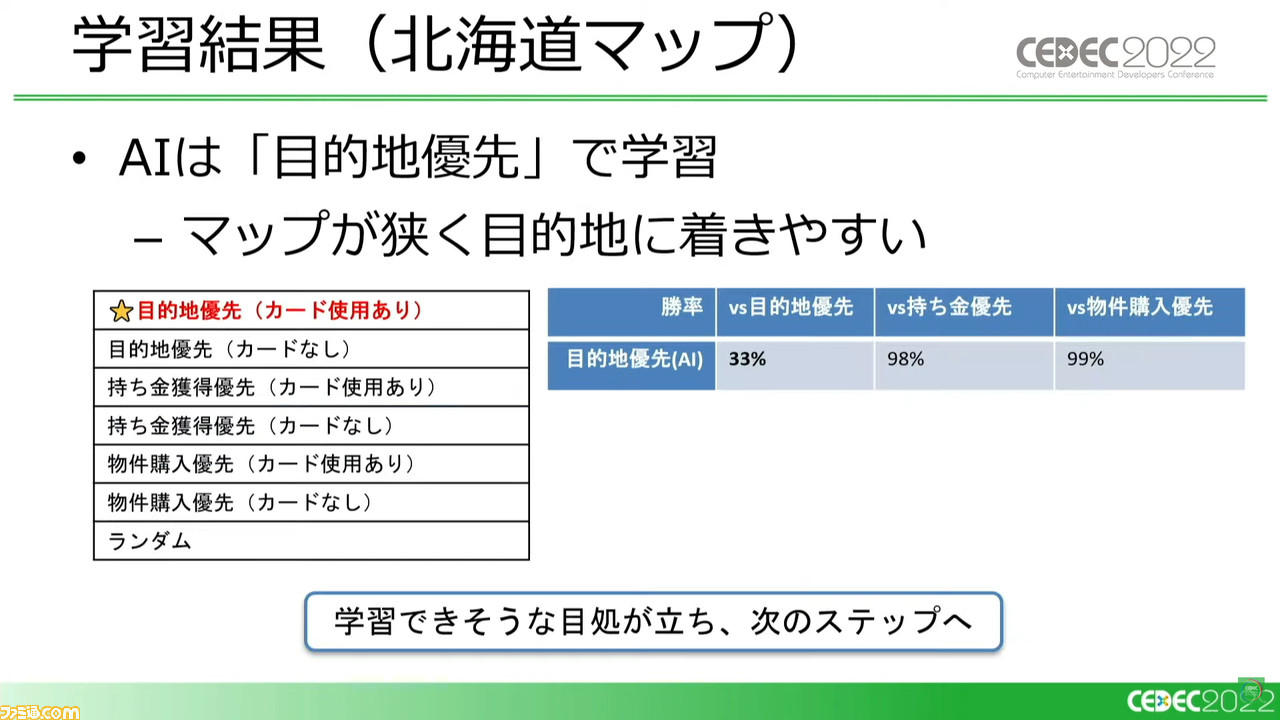

この条件で、勝率はどうなったのか。持ち金や物件を優先するCOMには“目的地優先”でほぼ完勝することができ、目的地優先のCOMに対してもベースラインを達成。この環境では、目的地を最短で目指すのが最善という結果が出た。

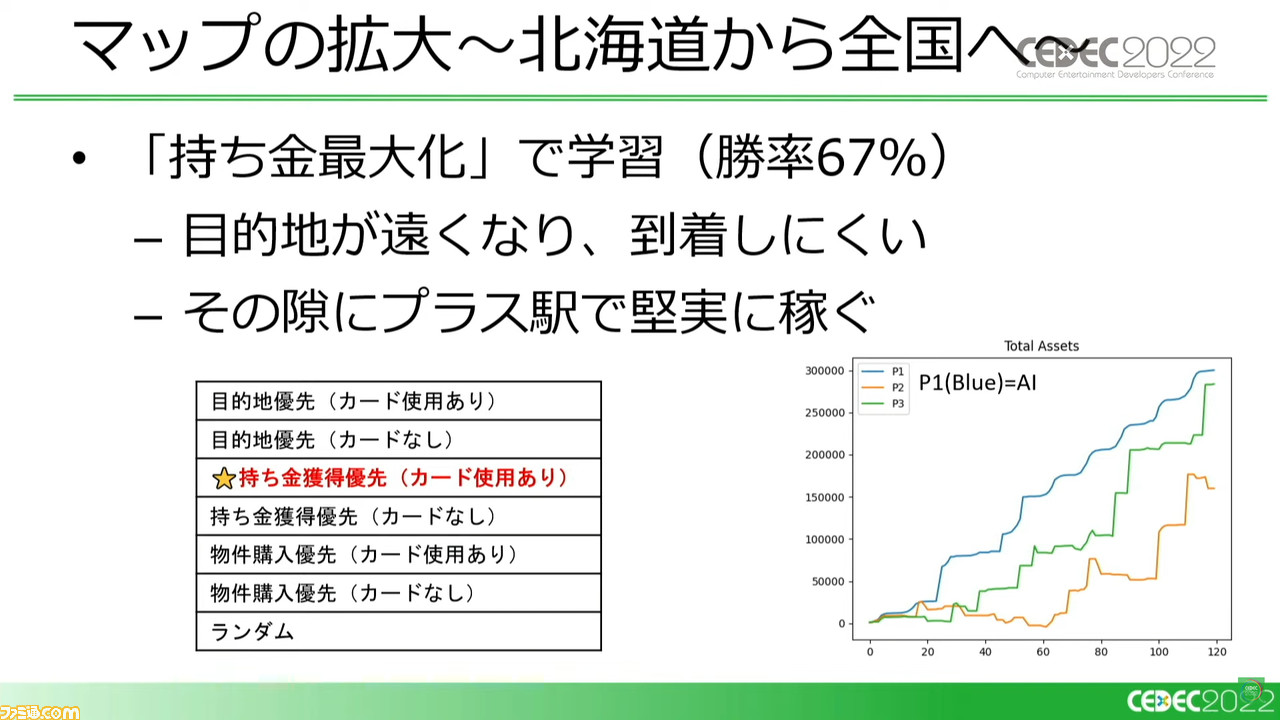

学習可能と判断できたところで、ゲーム本編からデータをシミュレーターへと移植していく。まずはマップを全国に広げてみたところ、さきほどの目的地優先ではなく、持ち金プラス駅に止まるために目的地に向かわずフラフラするほうが勝率が高まった。マップが広くなったことで目的地が遠くなり、目的地に到達したときに得られる“援助金”が得にくくなったのが原因だ。

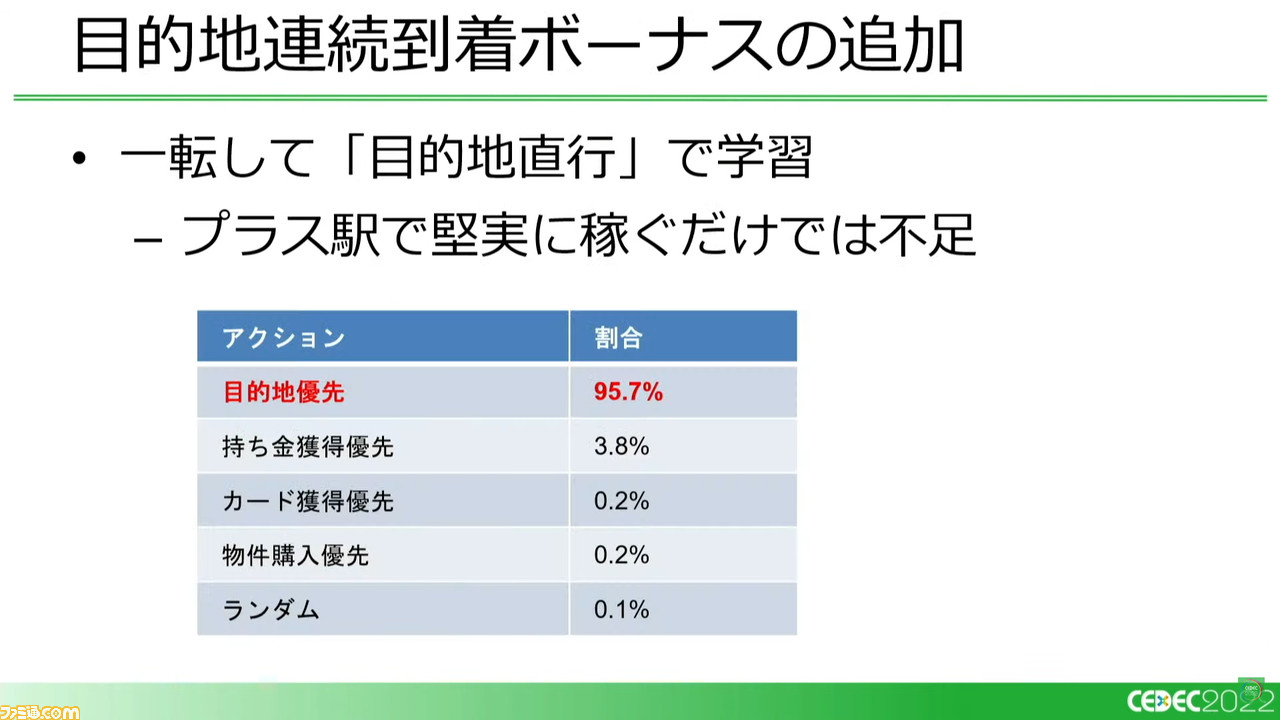

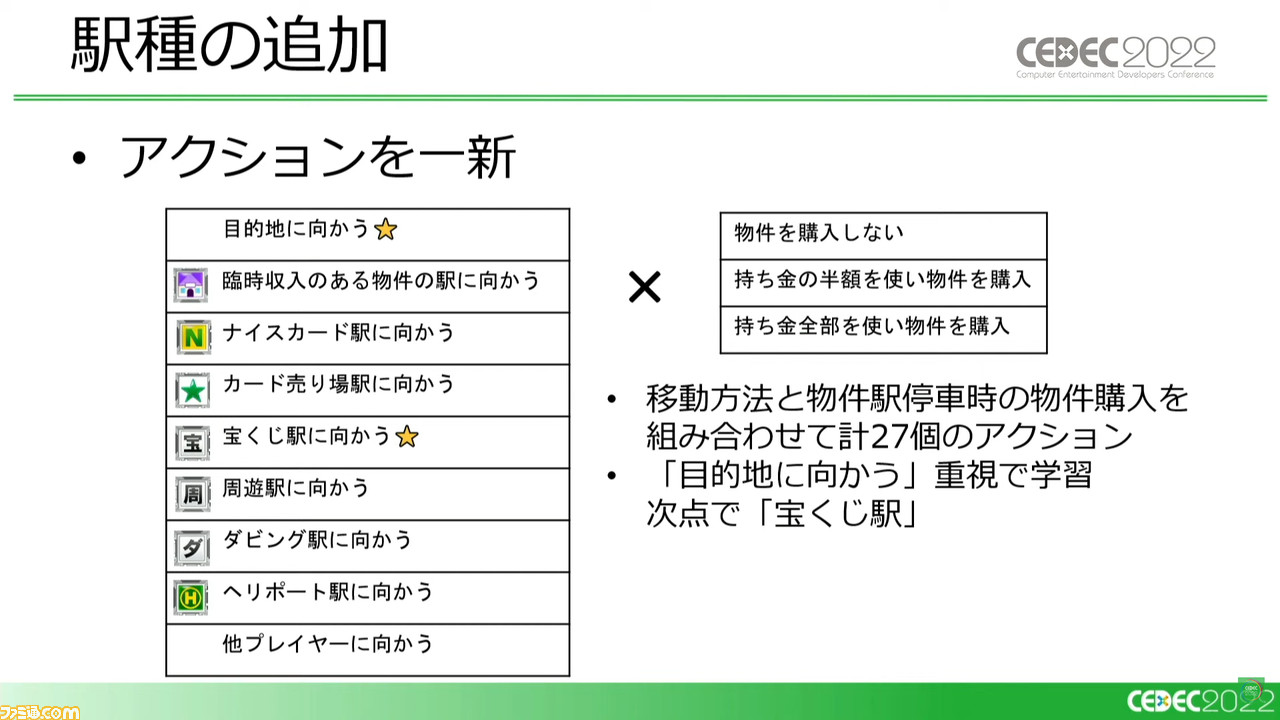

そこに“目的地連続到着ボーナス”を追加してみると、持ち金プラス駅で堅実に稼ぐだけでは足りないと、AIは一転して目的地を目指すように学習していく。さらに特殊な駅種を追加し、アクションを計27個に定義し直しても、目的地に向かうことを重視して学習していった。

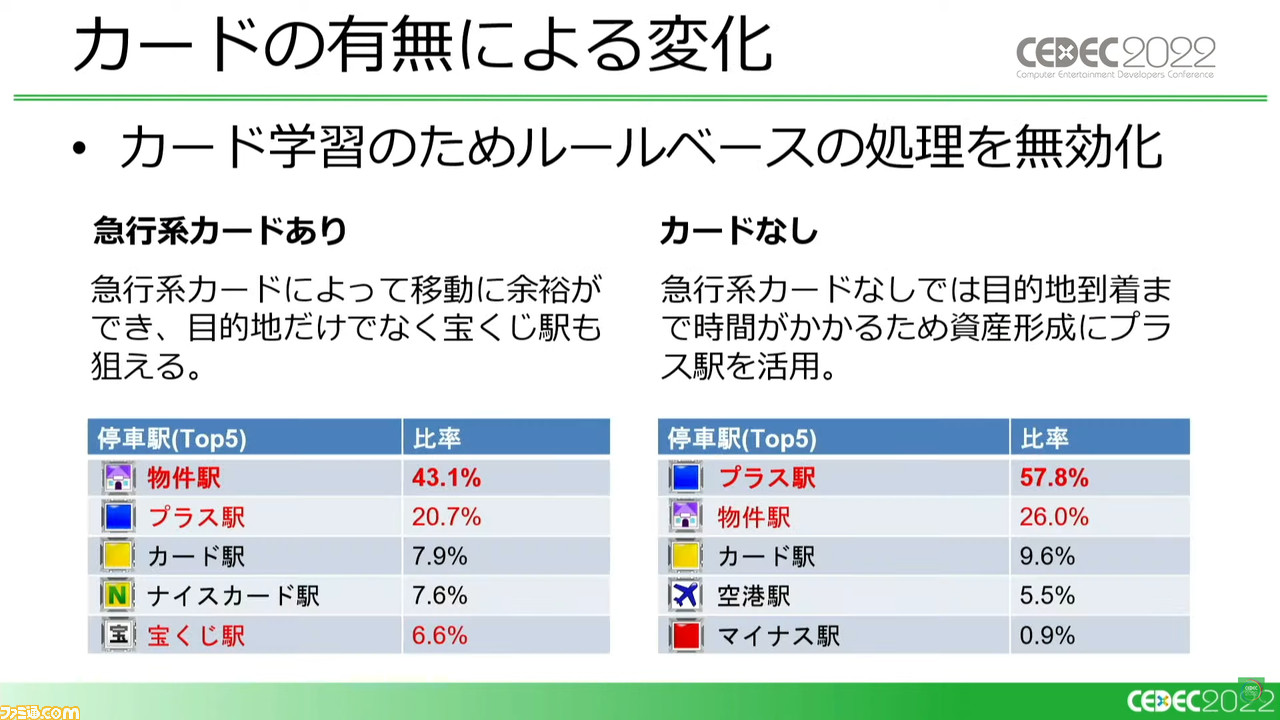

順調に学習が進んでいると判断し、ここまではサイコロを増やす急行系カードのみだったところに、全106種のカードをここで追加。アクションのパターンが一気に増えそうだが、実際はカード所持上限が8枚までなので、使用しない場合も含めると最大9アクションのみが有効になる。

このカード追加により、AIのプレイスタイルにも大きな変化が生まれた。一例として、目的地に向かわず資産を形成し、所持金を他プレイヤーと入れ替える“とっかえっこカード”を用いることで、目的地到達などを果たしたCOMからその資産を奪っていくという、スゴロクらしくない展開を見せていく。

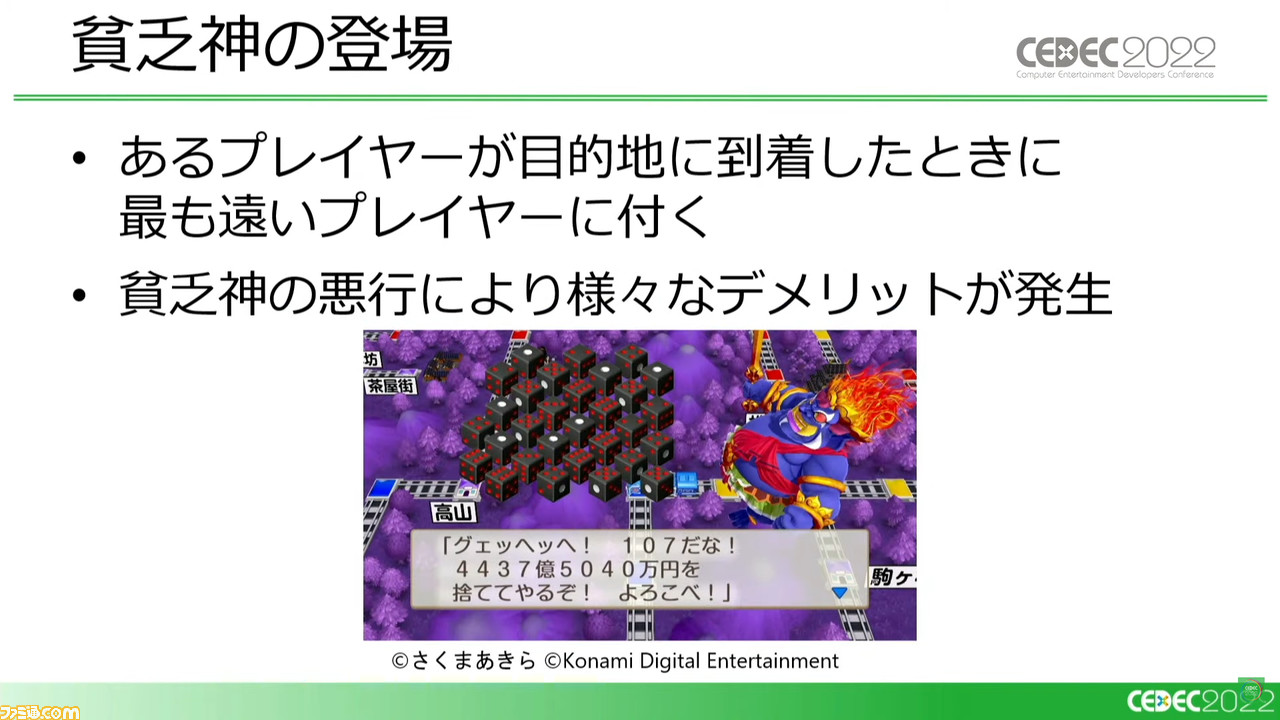

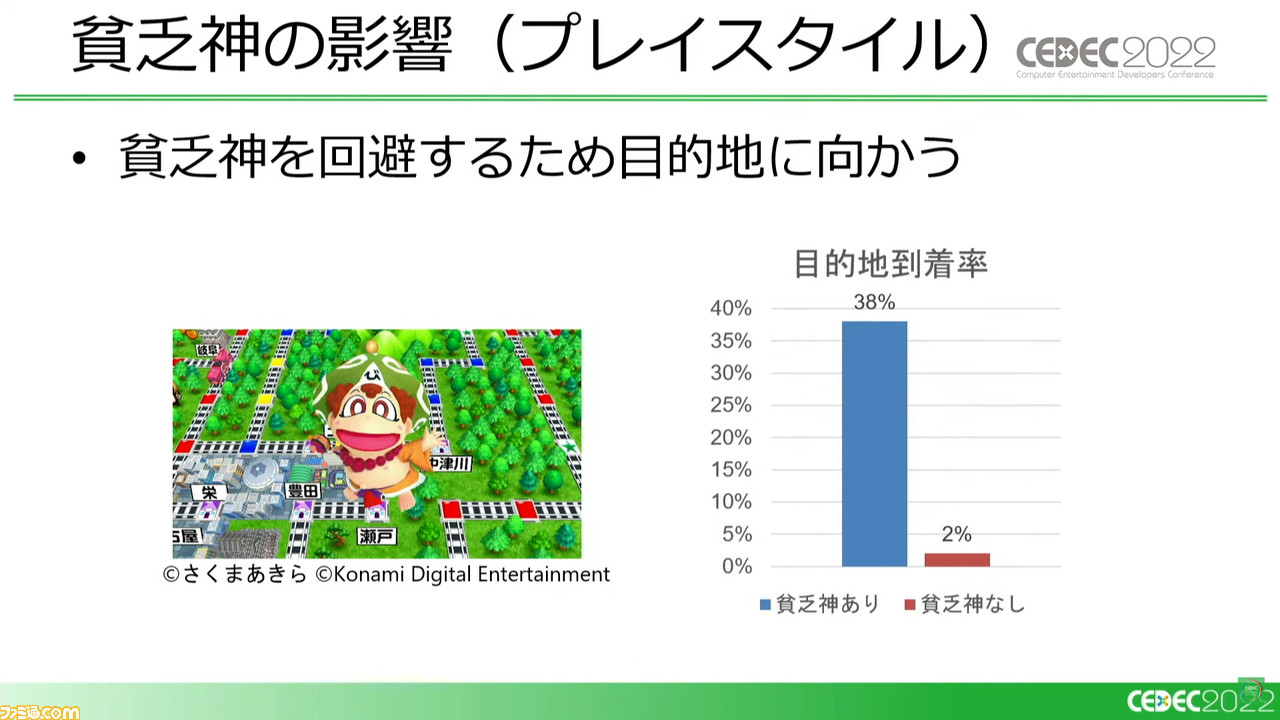

続いて、『桃鉄』ならではの要素“貧乏神”を追加。貧乏神は、いずれかのプレイヤーが目的地に到達したとき、その目的地からもっとも遠い位置にいたプレイヤーにとりつき、さまざまなデメリットを起こすキャラクターだ。この貧乏神にどう対応するかが、『桃鉄』の醍醐味のひとつでもある。

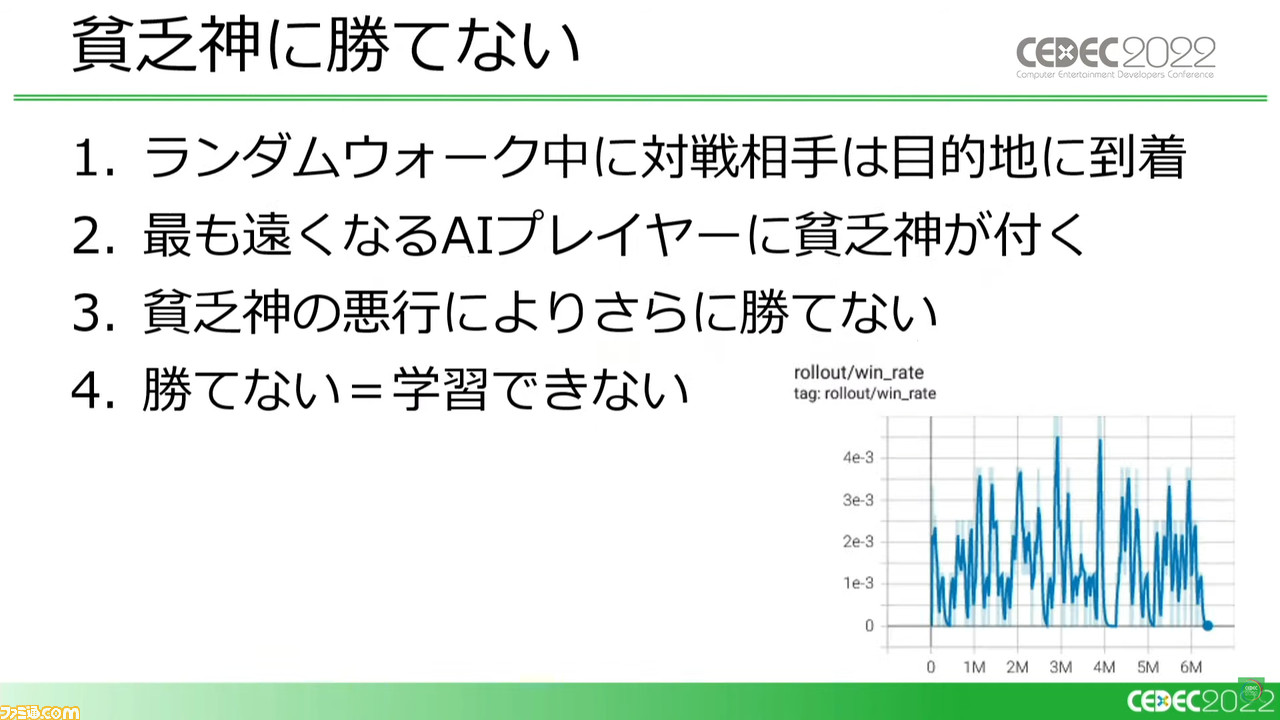

貧乏神の実装により、ここにきて初めて、学習における大きな問題が発生した。対戦相手がさきに目的地に着き、その資産をあとから奪うというさきほどまでのAIの学習では、必然的に貧乏神がAIについてしまう。これにより勝ち筋が見つけられず勝率は低空飛行を続け、学習できないという事態に陥った。

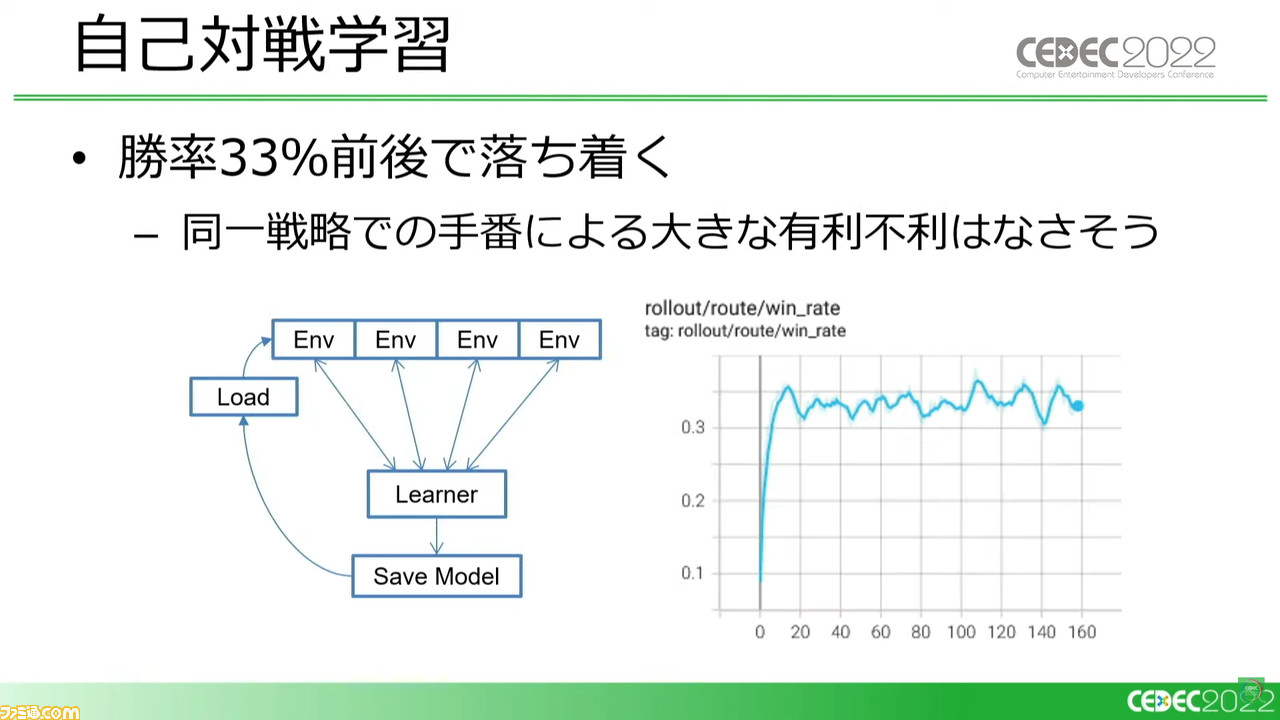

これまでは報酬やアクションの定義、ステートの修正で問題に対応できていたが、貧乏神にはこれだけでは足りない。そこで、ルールベースCOMに一定確率でランダム行動をとらせることで強さを調整したカリキュラム学習と、自己対戦学習を取り入れ、学習に成功した。

とくに自己対戦学習では、同じ戦略のAI3人が対戦することになるが、この状態で勝率33%のラインを維持できるということで、手番による有利不利の差もほとんどないことが実証できた。

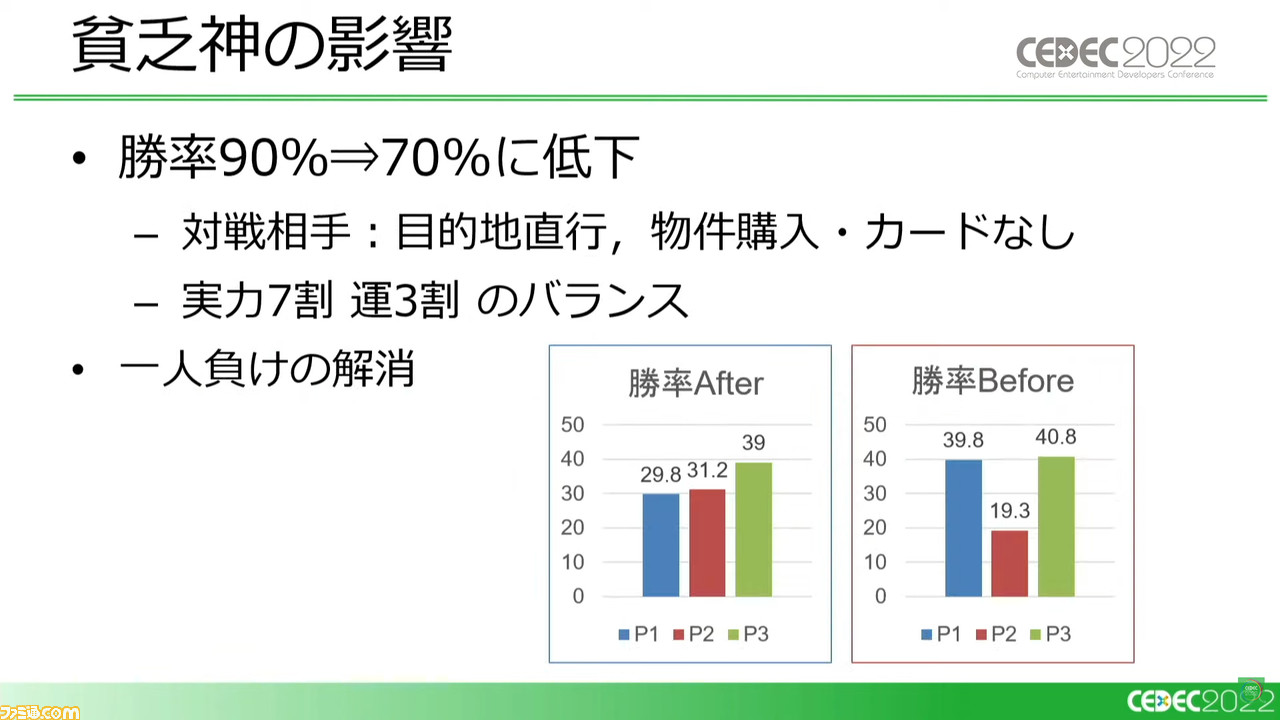

この事例から、貧乏神がもたらす効果も見えてきた。勝率9割をキープできていた環境においても、勝率は7割に低下。対戦相手のCOMはテクニックを弄さないで、3割勝利しているわけだ。実力7割、運3割といわれている本作のバランスが実感できる結果となった。

また、貧乏神実装前は戦略次第で一人負けするケースもあったが、実装後はプレイヤー間の勝率バランスもとれるようになっていった。また、AIは貧乏神を回避するために、資産強奪戦略よりも目的地到着を優先する方向で学習していく。

開発初期に「こんなゲームにしよう」という意思統一があっても、『桃鉄』のように豊富な要素をゲームプランナーがつぎつぎと投入していくと、それぞれが持っているゲームのイメージが変わっていく可能性がある。

そこで議論になることも多いだろうが、強化学習AIがあれば、バイアスがかかっていない観点から現状どのようなプレイスタイルのゲームになっているかを教えてくれるわけだ。また、ある仕様がどれくらい強いのかについても、定量的な比較結果が提示される。

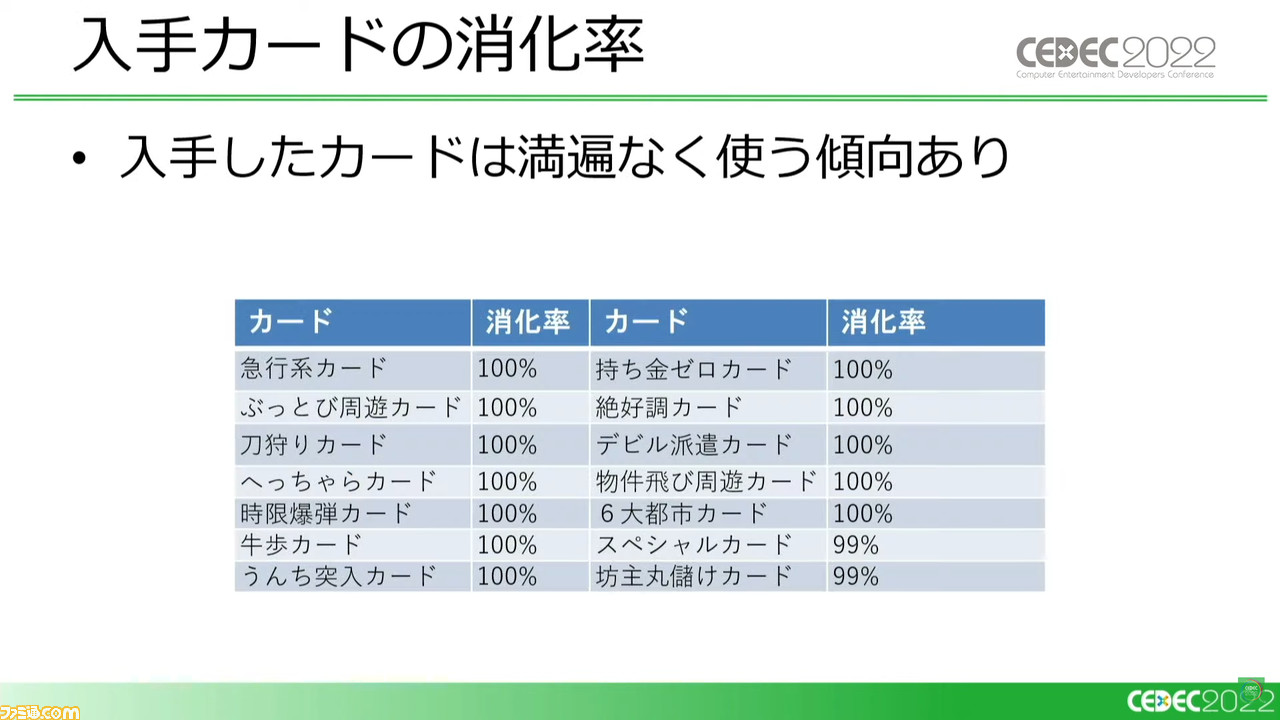

また、人間では目が滑りがちな、『桃鉄』の100種類以上のカードのような多彩な要素についても同様だ。すべて平等な目で見て、このカードが強いといった興味深いレポートを出してくれる。このような強化学習AIがいればゲーム開発における大きな求心力にもなり得ると、今回のAI使用事例の紹介は結ばれた。

10万回以上の試行でチェック体制を強力にサポート

講演では引き続き、シミュレートではなく実際に行なった事例として、『実況パワフルサッカー』における強化学習AIを用いたバランス調整の支援について紹介された。

同作開発現場においては、AIのバランス調整活用の研究開発に1年を費やし、さらに2年間、実際の運用を行なっているとのこと。そのなかでは強化学習以外のAIも活用しているが、今回の講演では強化学習の活用にフォーカスした。

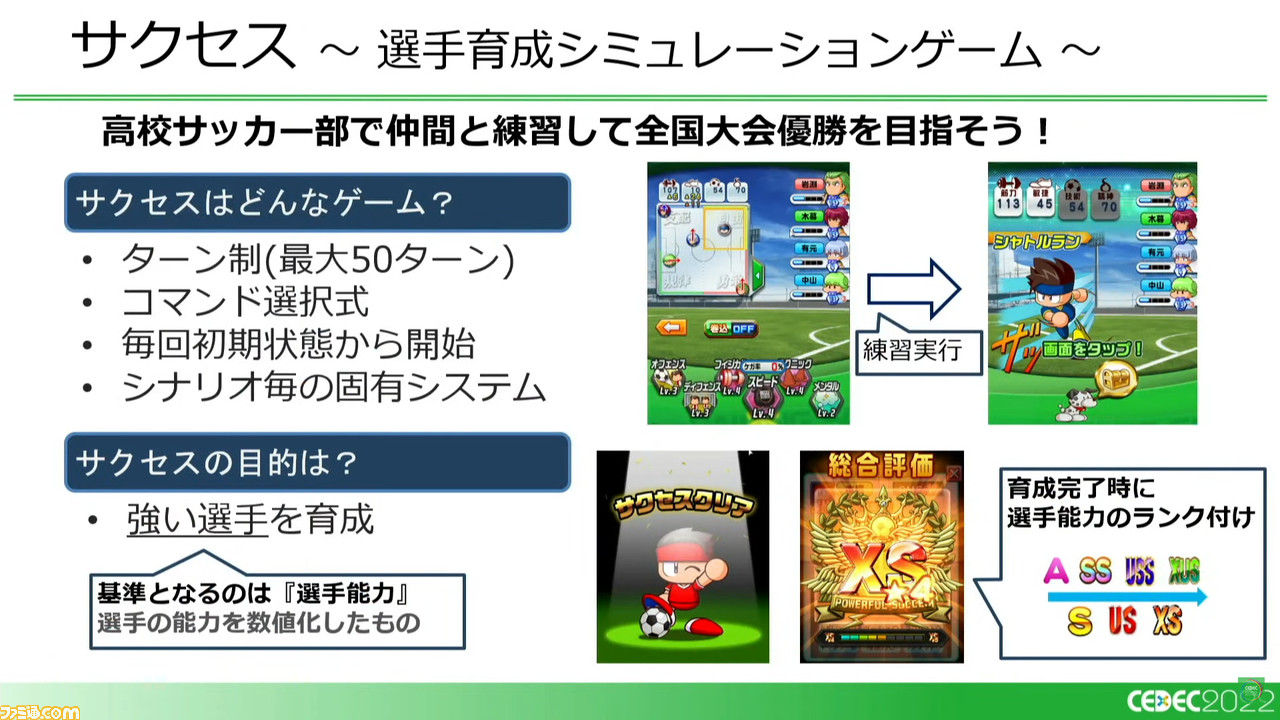

『パワサカ』は2016年から配信開始されたタイトル。プレイヤーは選手の人生を描く“サクセスモード”でキャラクターを育成し、自分だけのチームを作っていくことができる。

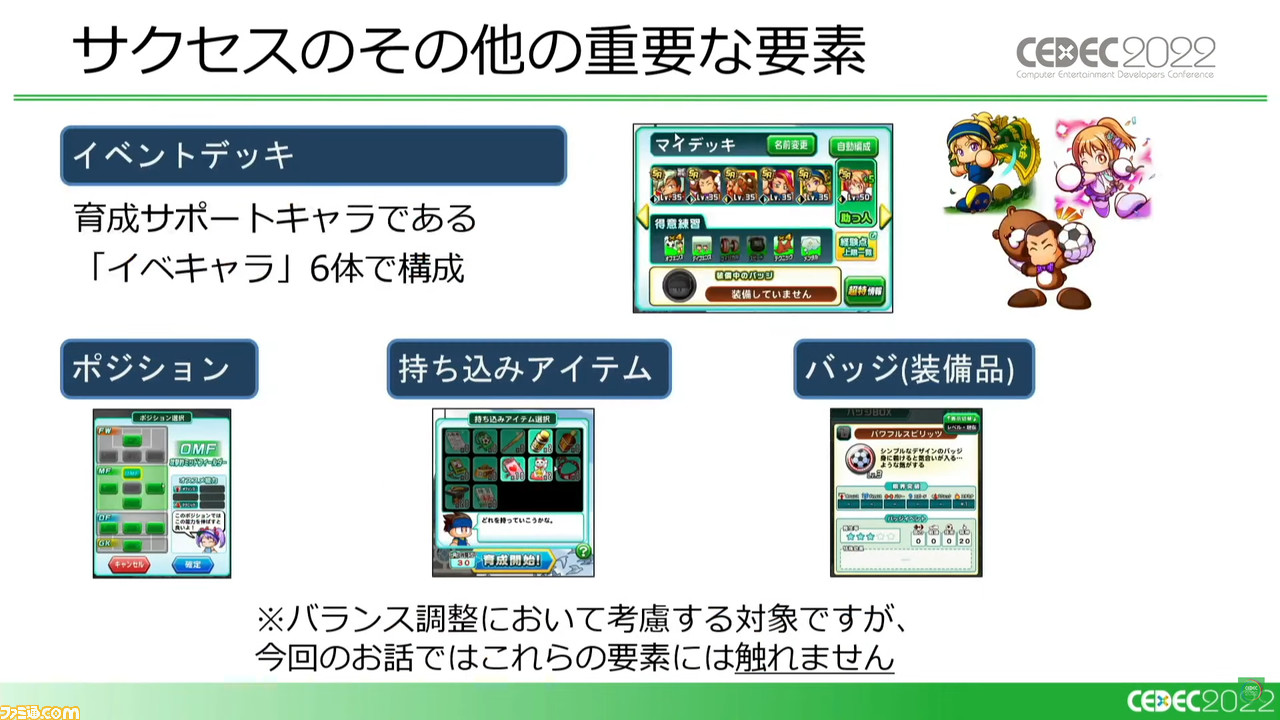

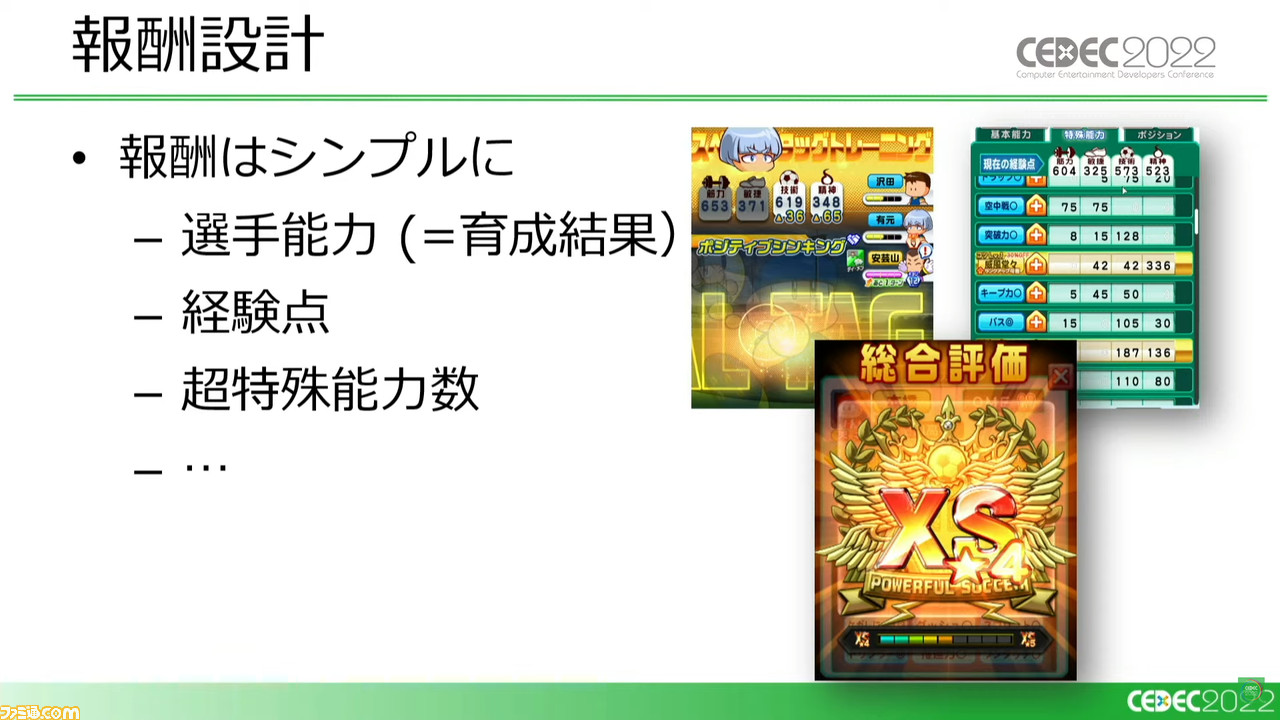

サクセスはターン制かつコマンド選択式、プレイするたびに初期状態から開始されるといった点に加え、選択した“シナリオ”ごとに異なる固有のシステムを持っているという点も特徴としている。また、選手の能力を数値化した“選手能力”に従って、総合評価が決まる。

また、シナリオの選択は主人公が通う高校の選択でもある。どの高校に通うかによって物語が変わるだけではなく、他の学校での武者修行や、モンスターの育成、航海、ビンゴゲームなど、サッカーに関係しないものも含めてまったく異なる新鮮な体験ができる。他のさまざまなシステム同様に、強い選手を育成するには、これらの理解も重要になるわけだ。

では、このサクセスのバランス調整とは具体的にどういった目的で行なわれるものなのか。育成ゲームであるため新コンテンツの追加ごとに環境が大きく変化するが、そのなかでもシナリオ追加による影響は大きい。バランス調整は、コンテンツが想定通りの影響を及ぼすように進めていく。

本作のバランス調整は非常に重要でありながら、かなり難しい案件でもある。検証にかかる時間はもちろん、高いプレイスキルや経験がテスターにないと、実際のプレイヤー層との乖離が起こるほか、先入観による誤った判断を下す可能性はどうしてもつきまとう。

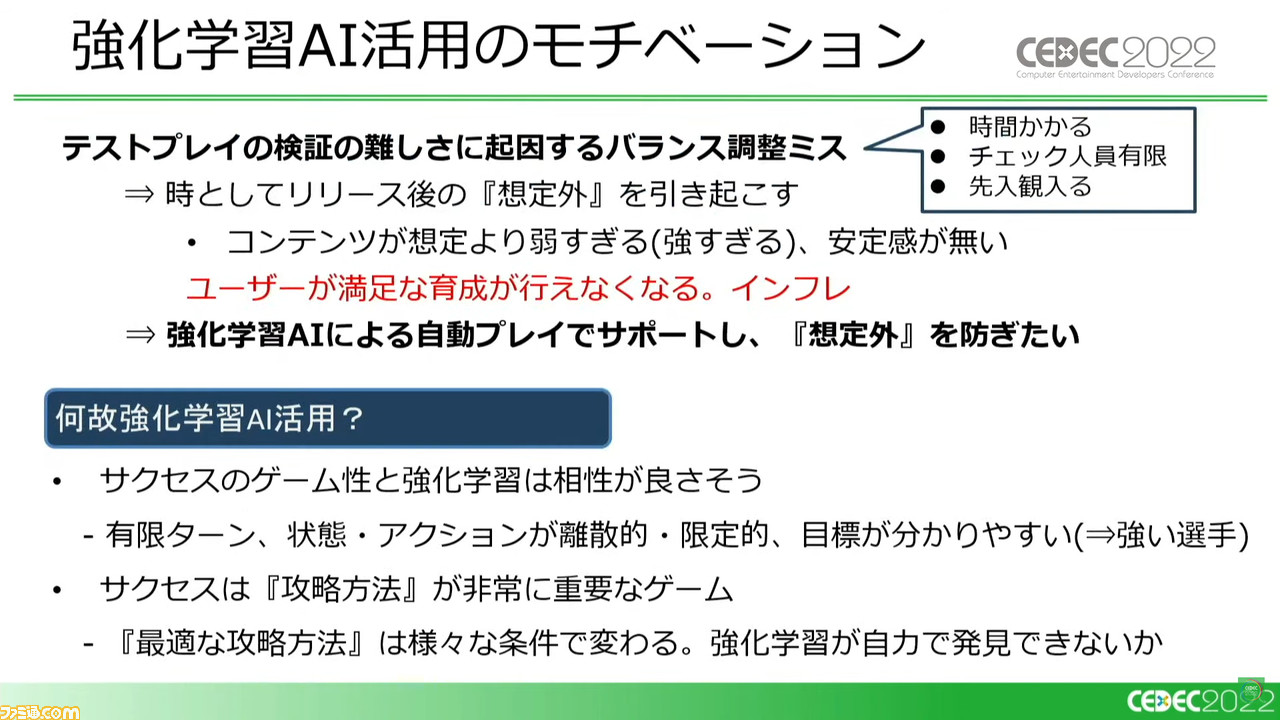

この難しさに起因するミスは、さまざまな想定外の事態を引き起こしてしまいかねない。これを防ぐために考えられたのが、強化学習AIによるバランス調整のサポートだ。

強化学習AIの導入を考えた理由については、ターンやアクションが限定的、かつ目標(価値)が明確であるサクセスのゲーム性との相性の良さに加え、人間ではかなり手間取る攻略方法の発見についても可能ではないかという推測があったとのこと。

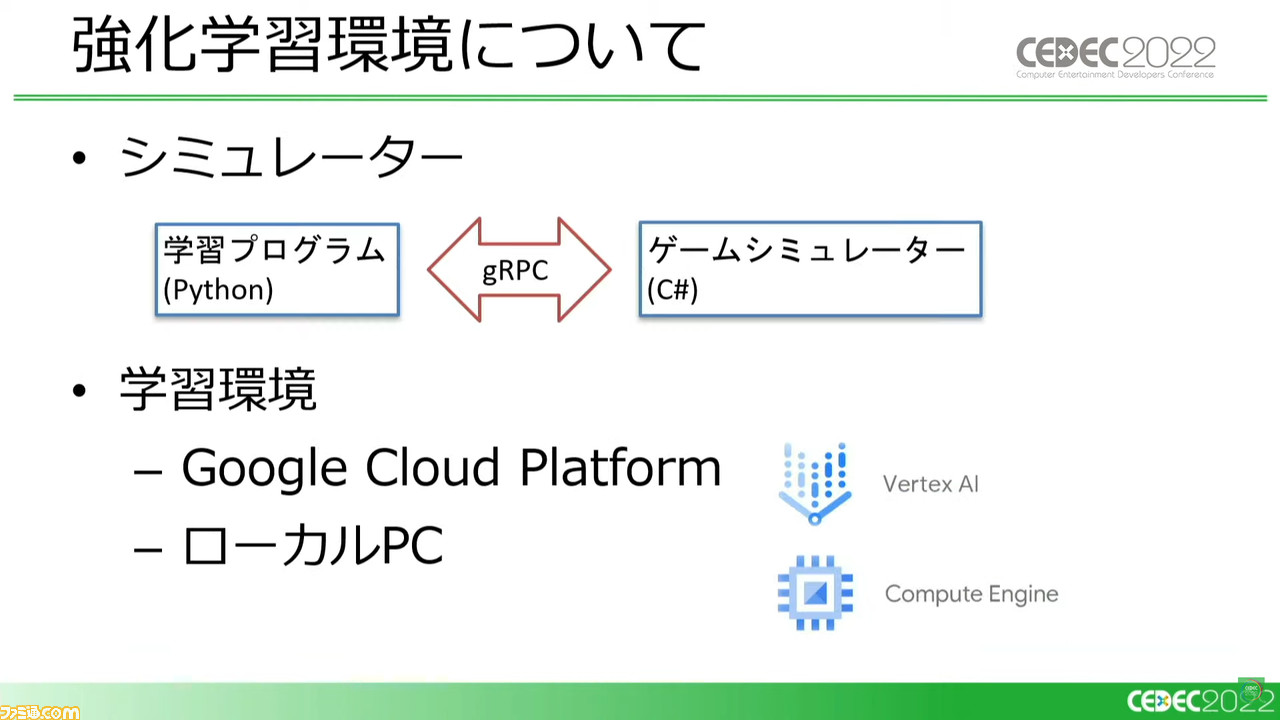

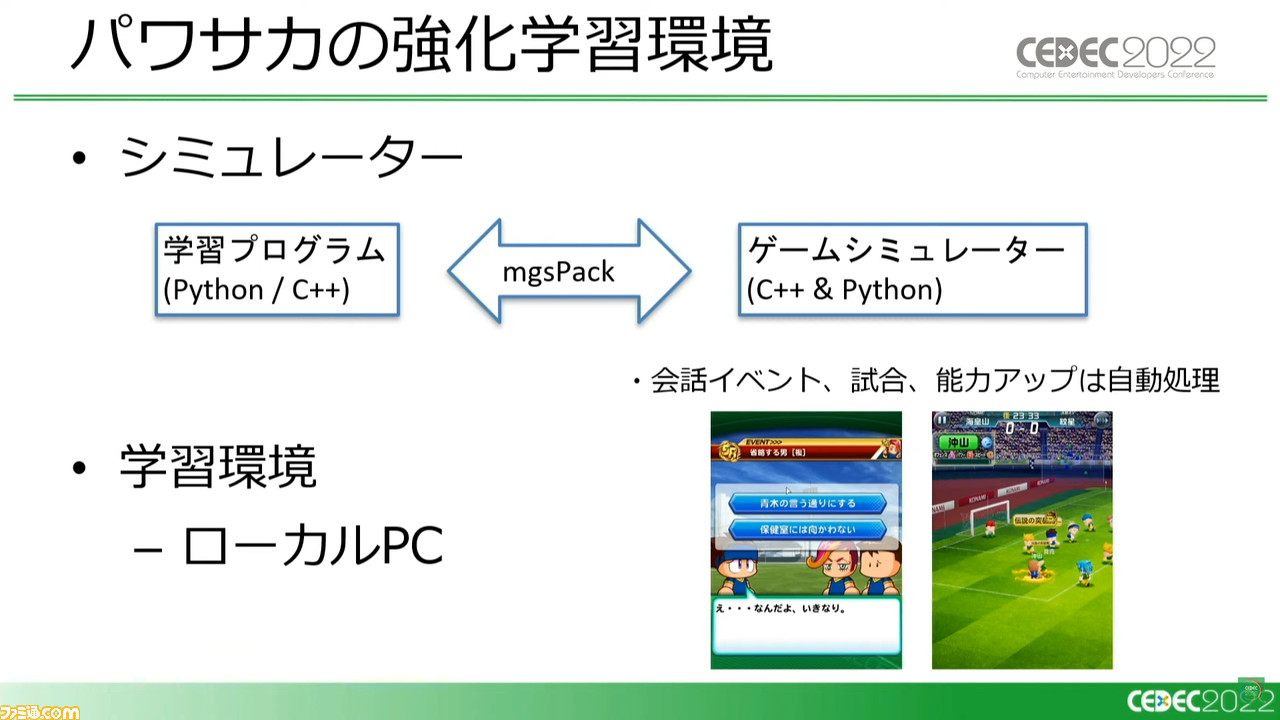

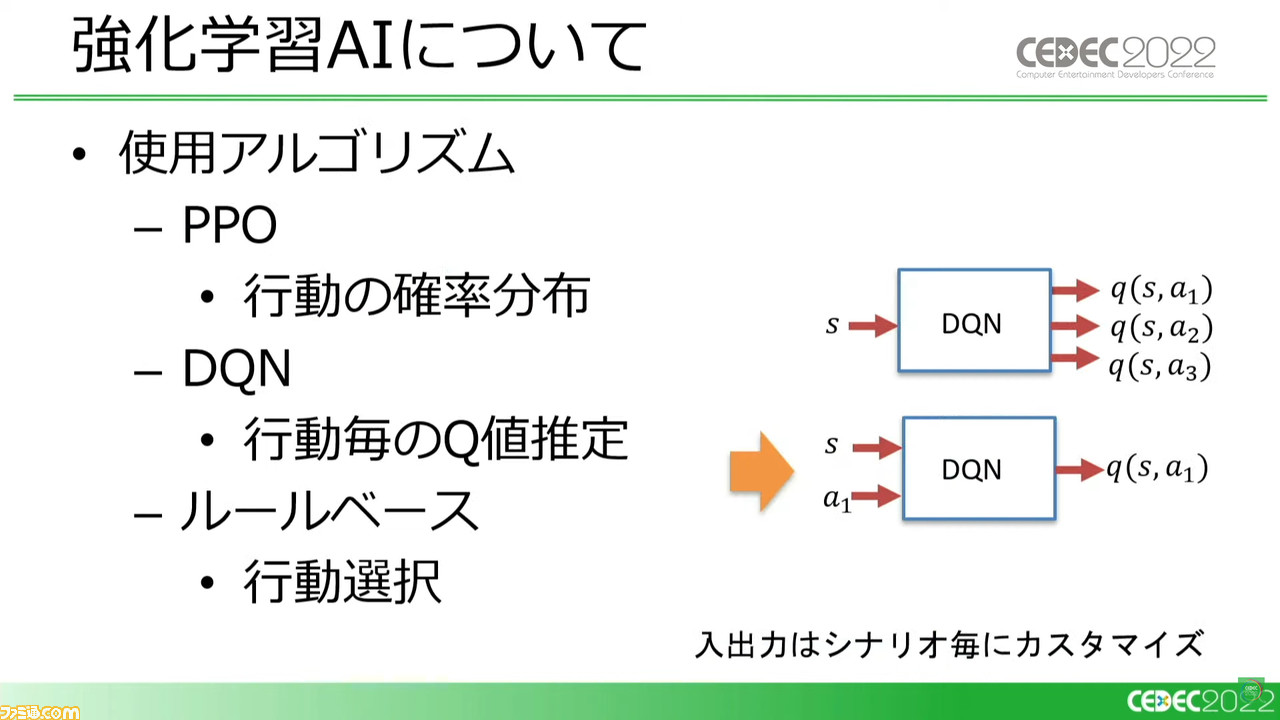

講演では引き続き、実際にどのような環境で強化学習を行なったのかも紹介された。ローカルPCを複数台併用し、C++とPythonで構築したシミュレーターと学習プログラムを使用。さらにPPOとDQN(※)という、ふたつのアルゴリズムを別々の担当者に割り振り、さらにロジックベースのAIも併用。

また、DQNについてはステートのみではなくアクションを同時に入力することで、実際にできる行動が少ない場面ではより良い学習ができるのではと考えた。

※PPO(Proximal Policy Optimization): 直接方策を改善する勾配を求めていく、現在の方策によって得られたサンプルのみを学習に使用するアルゴリズム。

※DQN(Deep Q-Network); 特定状況下でとった行動の価値をQ値として管理し、近似関数によってもっともQ値が高い=取るべき行動を推測、判断できるアルゴリズム。

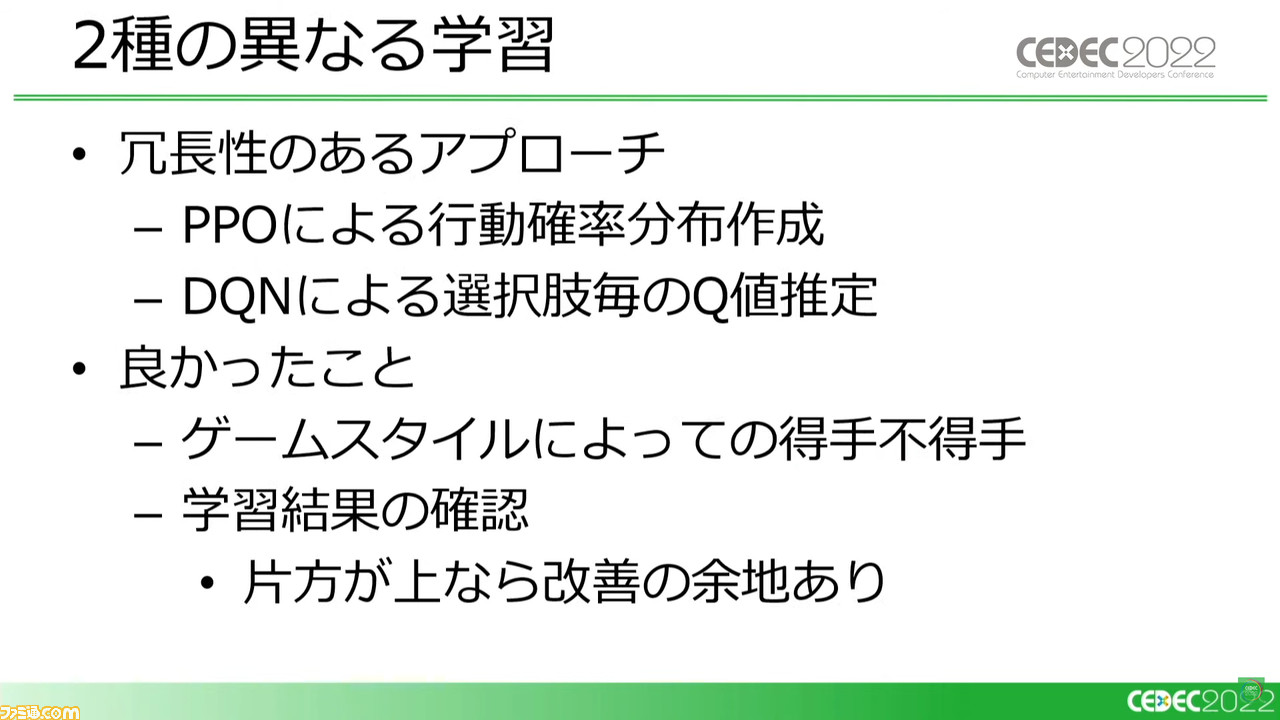

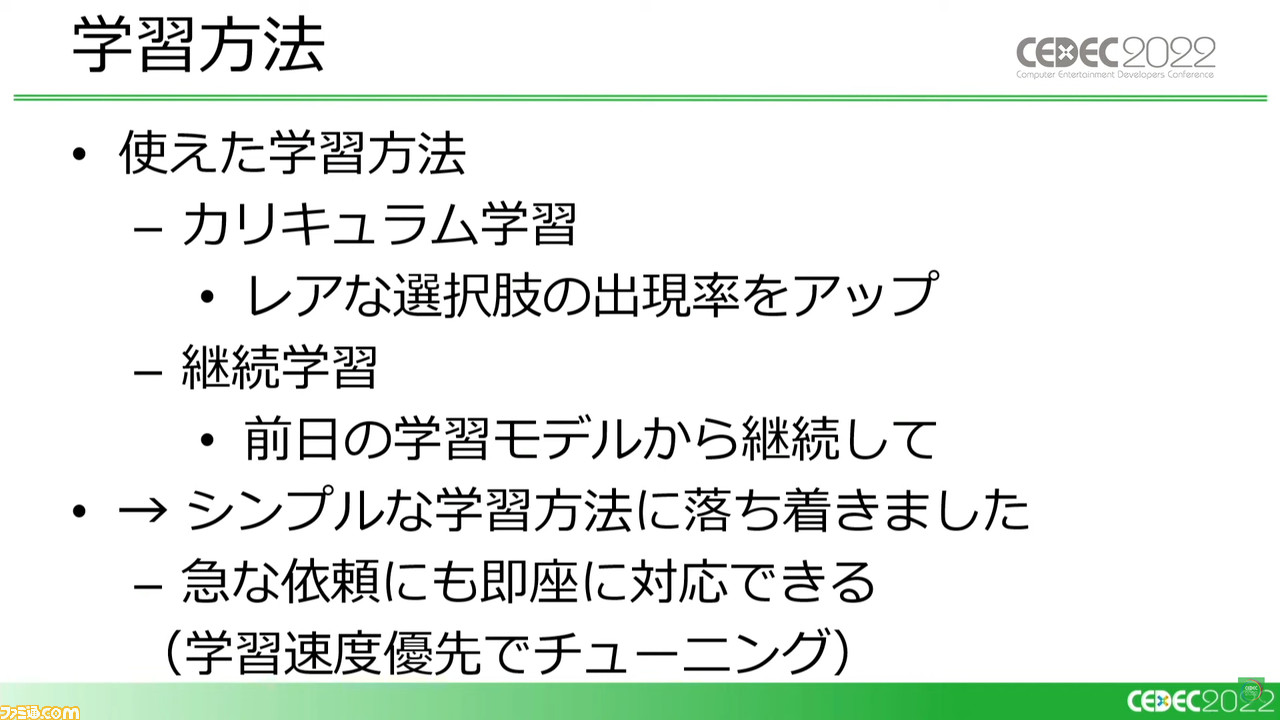

ふたつのアルゴリズムを使うとなると冗長性が出てしまうのではと思われるが、シナリオにより大きくゲーム性が変わる『パワサカ』では、片方のアルゴリズムでは学習に失敗してももう一方が成功するなど、得手不得手の割り振りができたのが利点となった。

また、プランナーが新要素を設定した直後、はじめてプレイするのがAIという場面もある。そのような場合、この学習がちゃんと成功しているかどうか判断しかねて不安が生じることもあるが、ふたつのアルゴリズムが並行することで、同じくらいの結果が出るなら成功に確信が持てたり、片方が上の結果を出すなら何らかの取りこぼしの可能性が考えられたりと、判断材料が生まれる。

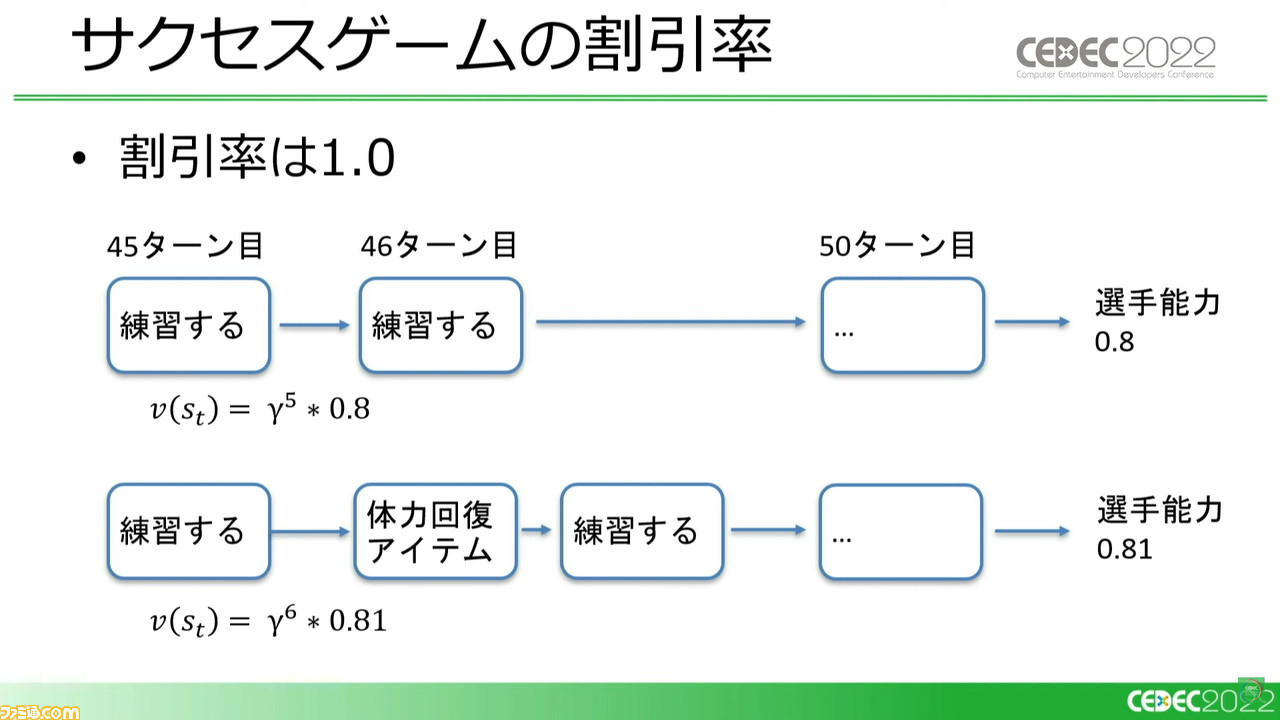

こうしたシンプルな学習方法のなかでも、面白い事例が起こった。あるゲームプレイでは連続したターンで練習を選択した場合と、別のゲームプレイで練習2回のあいだに体力回復アイテムの使用を挟んだ場合、結果は同じはずなのにV値に差異が生まれた。つまり、手数が多いプレイをAIが避ける傾向が生まれかねない。

実際には体力回復アイテムの使用には、ゲーム内のターンなどといった時間の経過は起こらないのだが、強化学習においては手数として判断されたのだろう。割引率(※)を1.0と定義することで、この事態は解消できた。本来ならアイテムを使用しつつ練習する、という新たなひとつの行動を定義するべきだが、その方法ではアクション定義数が増え、学習速度優先のスタンスに相反してしまう。

※割引率: 将来獲得できると予想される価値を、現在の価値に換算した際、価値がどう変動するのかを定めた係数。

こうした事例もあったものの、実際に『パワサカ』で稼働した強化学習AIは、シナリオによる相性などもあったものの十分な性能を発揮した。その試行プレイ回数は、10万~20万回にも及ぶという。

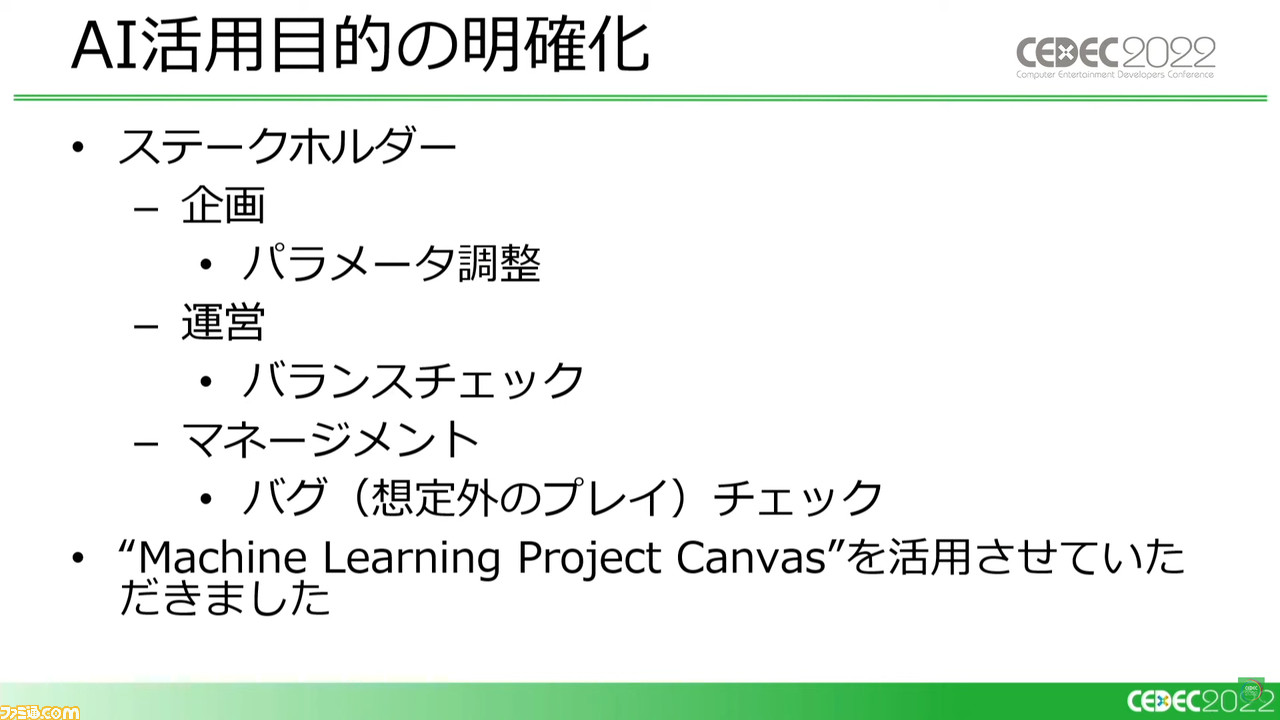

開発終盤ではその実績にさまざまな人が興味を持ってくれたとのことで、バランス調整以外の活用例もいろいろと考えられた。その場面では、使用目的や使用者によってAiの使い勝手は大きく変わるため、だれがどのような目的でAIを用いるのかについては、三菱ケミカル株式会社のMachine Learning Project Canvasに書き込んで明確に管理したとのこと。

いままでAIを使っていなかった人が初めて使うという場合などにおいて、新たなタスクがフローに追加されることに不安を覚えたり、AIが出す結果に信用をおけるかどうか懐疑的になる可能性も高いと考えられる。

だが今回の事例では、開発初期の段階で非常にランクの高い選手をAIが育成し、明確な結果を示すことによって、さまざまな敷居を越えることができたという。導入を推し進める際には、簡単で分かりやすい指標の提示も大事ということだ。

AI運用の現状を解説。任せきりではない“相互協力”が重要

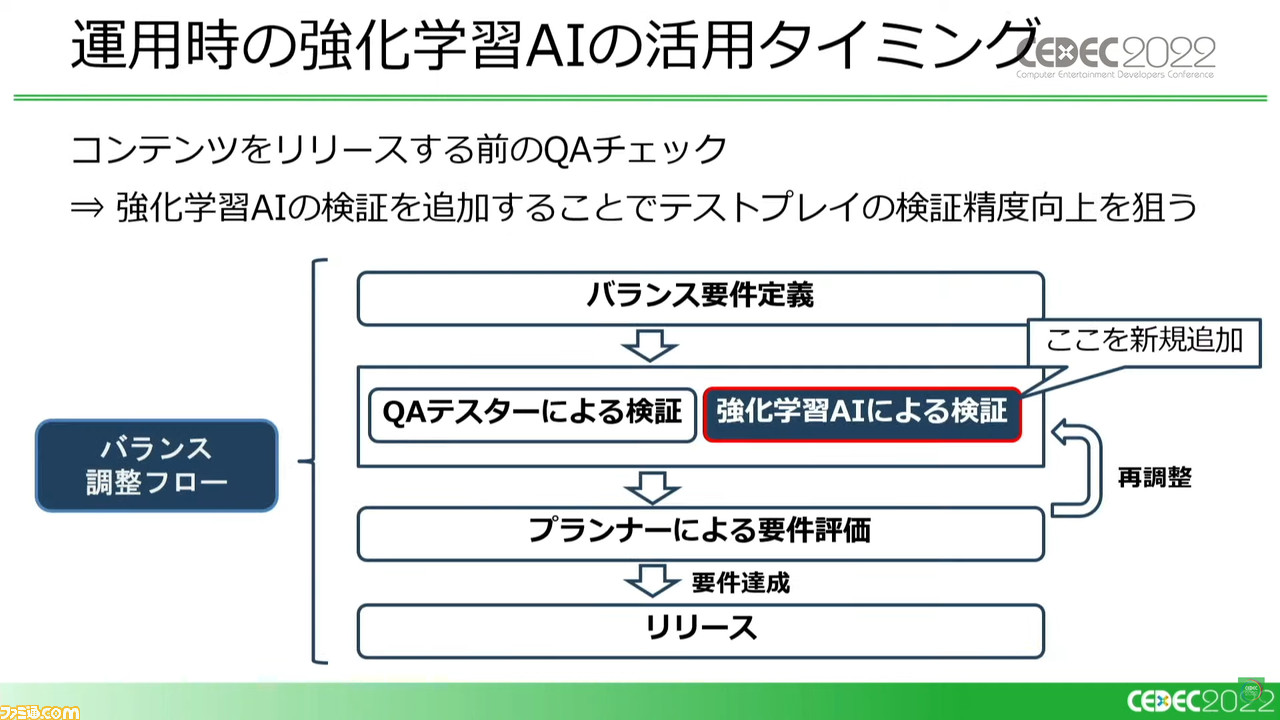

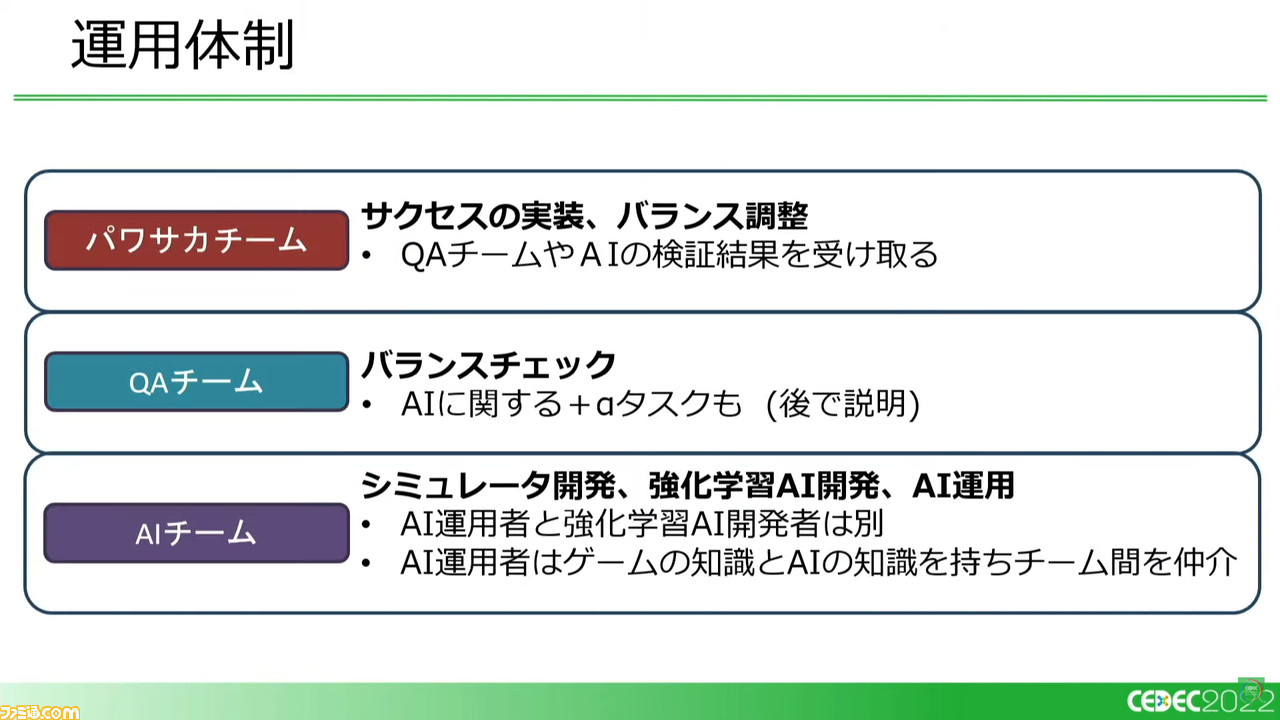

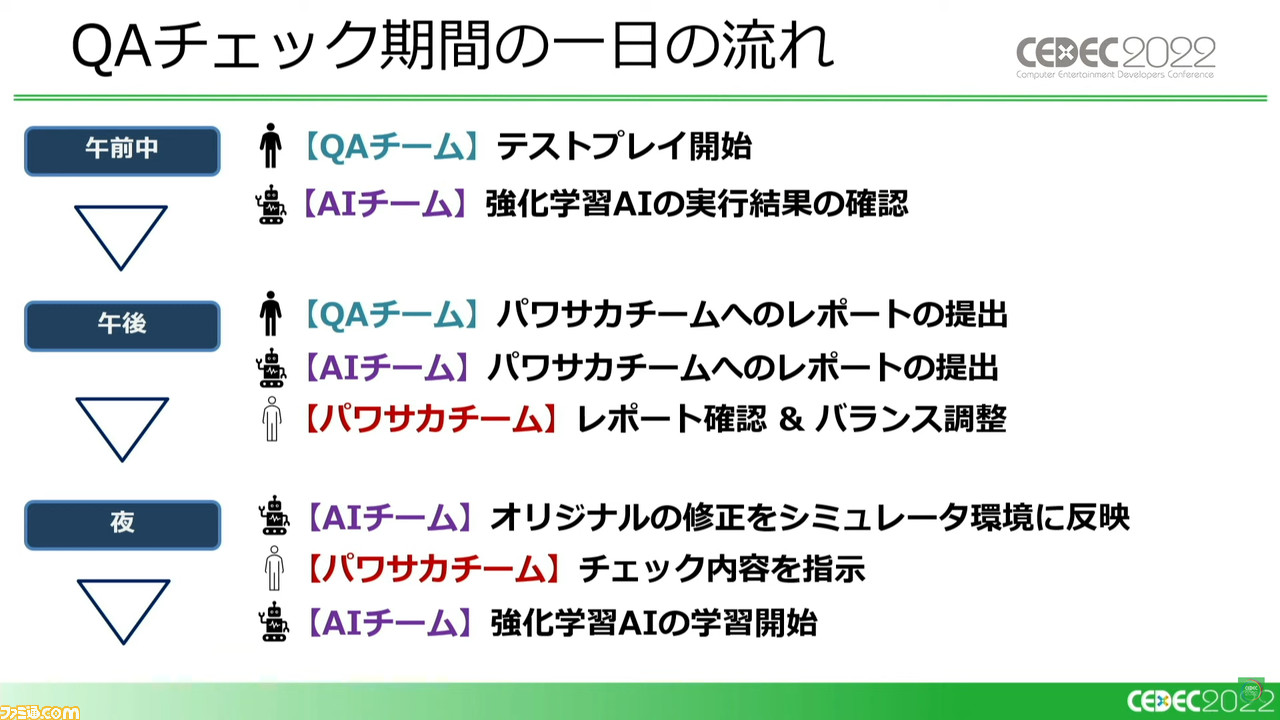

続いて講演では、実際の『パワサカ』運営における現在の強化学習AIの活用状況が解説された。現在では新規シナリオ実装前などのQA(品質保証)チェックに、QAテスターの検証と併用して強化学習AIの検証が追加されている。

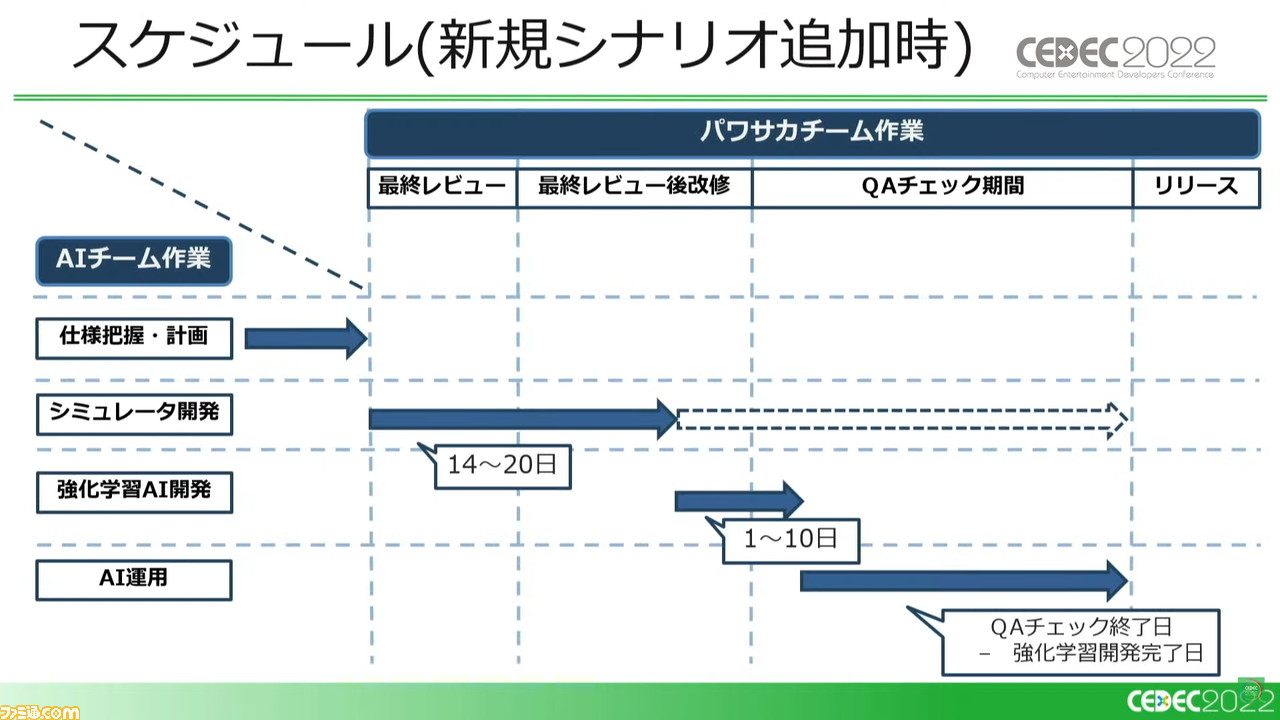

運用スケジュールについては、開発スケジュールに綿密に合わせていく必要がある。シナリオ追加などでシミュレーター開発の必要が生じない場合は、強化学習AIの対応も必要ないため、わずかな対応コストですぐにチェックを開始できる。

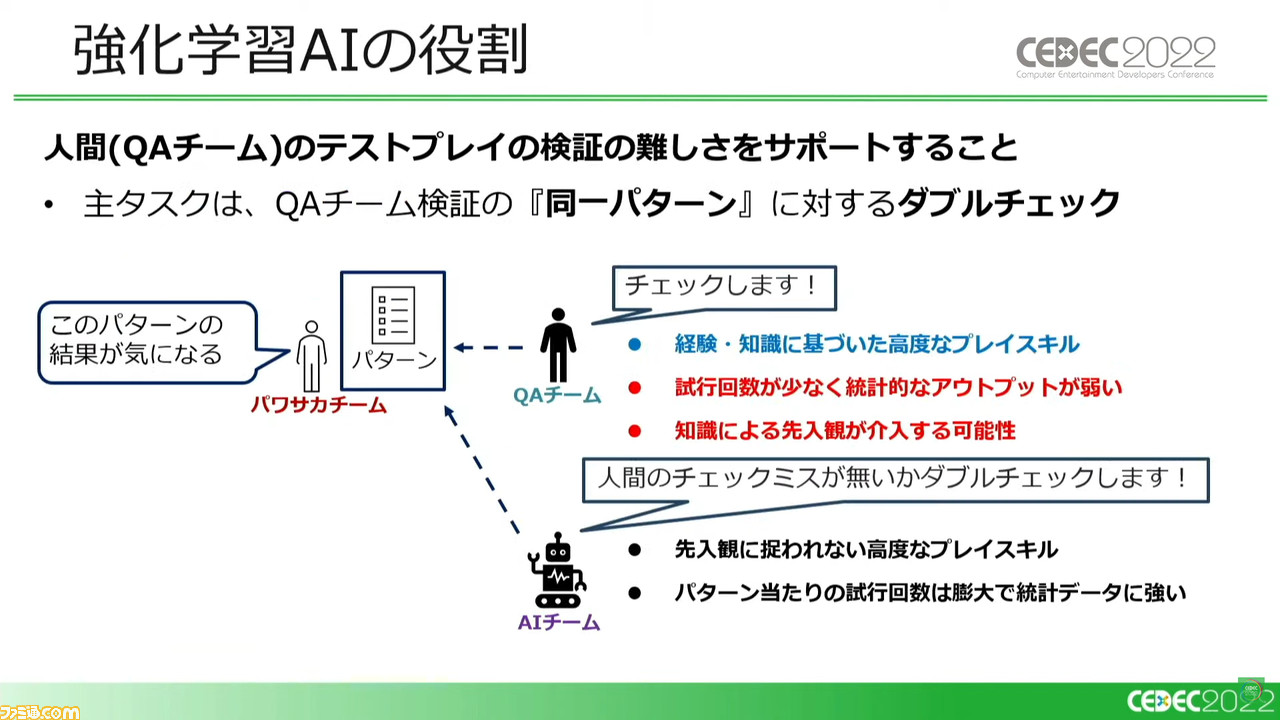

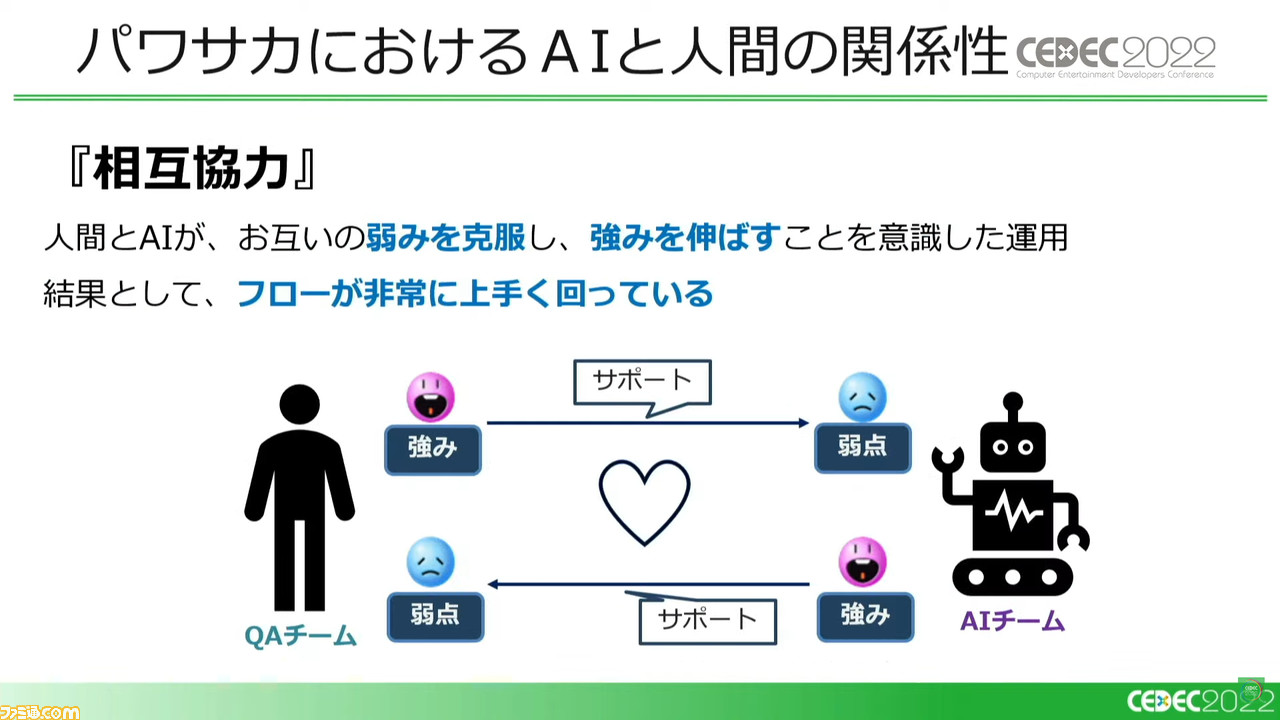

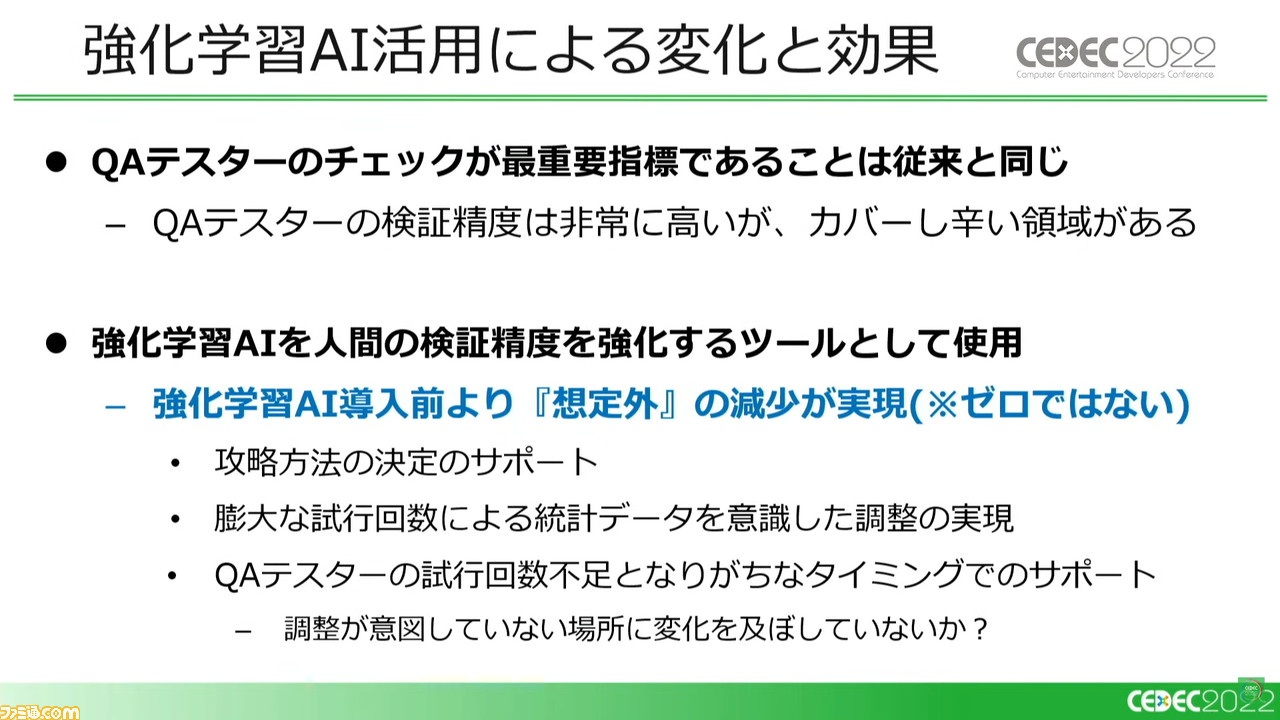

このフローのなかで強化学習AIが果たすべき役割は、人間(QAチーム)の検証の難しさをサポートすることにある。試行回数の少なさや先入観の問題を補う、同一パターンに対してのダブルチェックを担うわけだ。

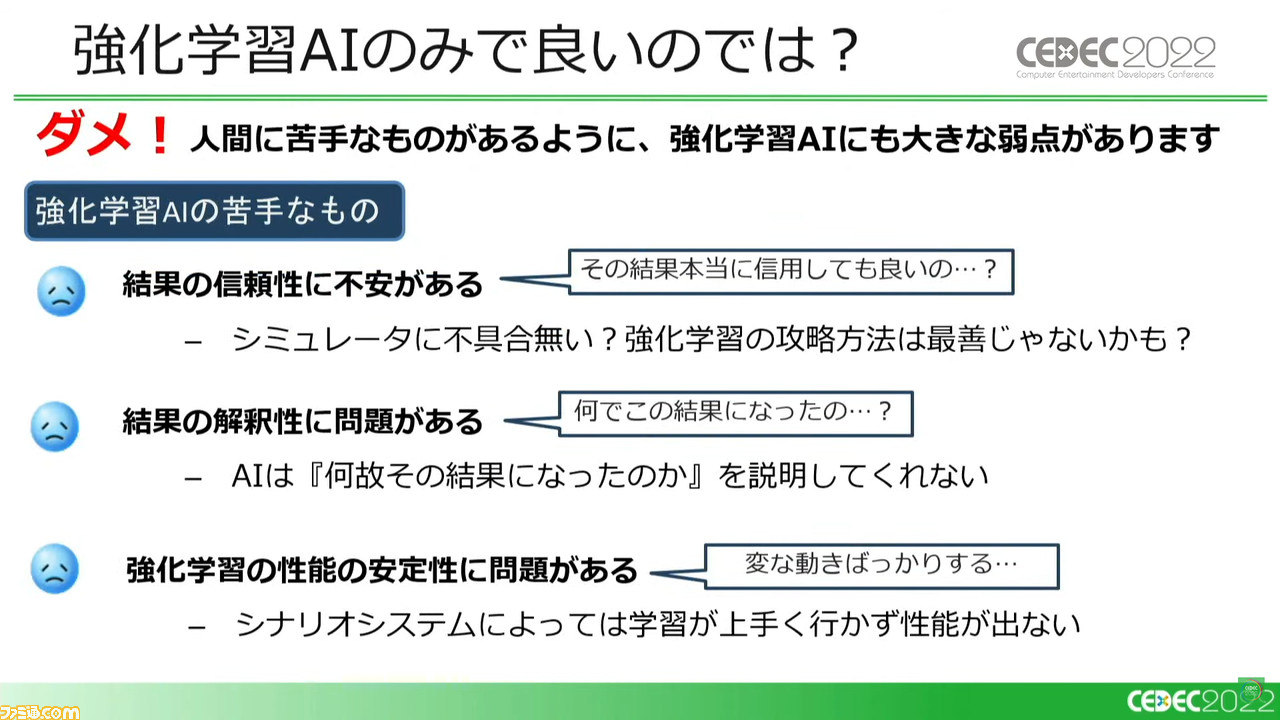

長い運営期間のあいだに、『パワサカ』の強化学習AIは人間と遜色ないプレイ能力を獲得している。だが、それでもAI単体での人間いらずのチェック体制は期待できない。シミュレーターの不具合の可能性などから単一での結果の信頼性には不安がどうしても残り、ほかにも結果に対する説明がない点や、多彩なシナリオに対して挙動が不安定になる場合がある点など、まだまだ苦手が存在する。

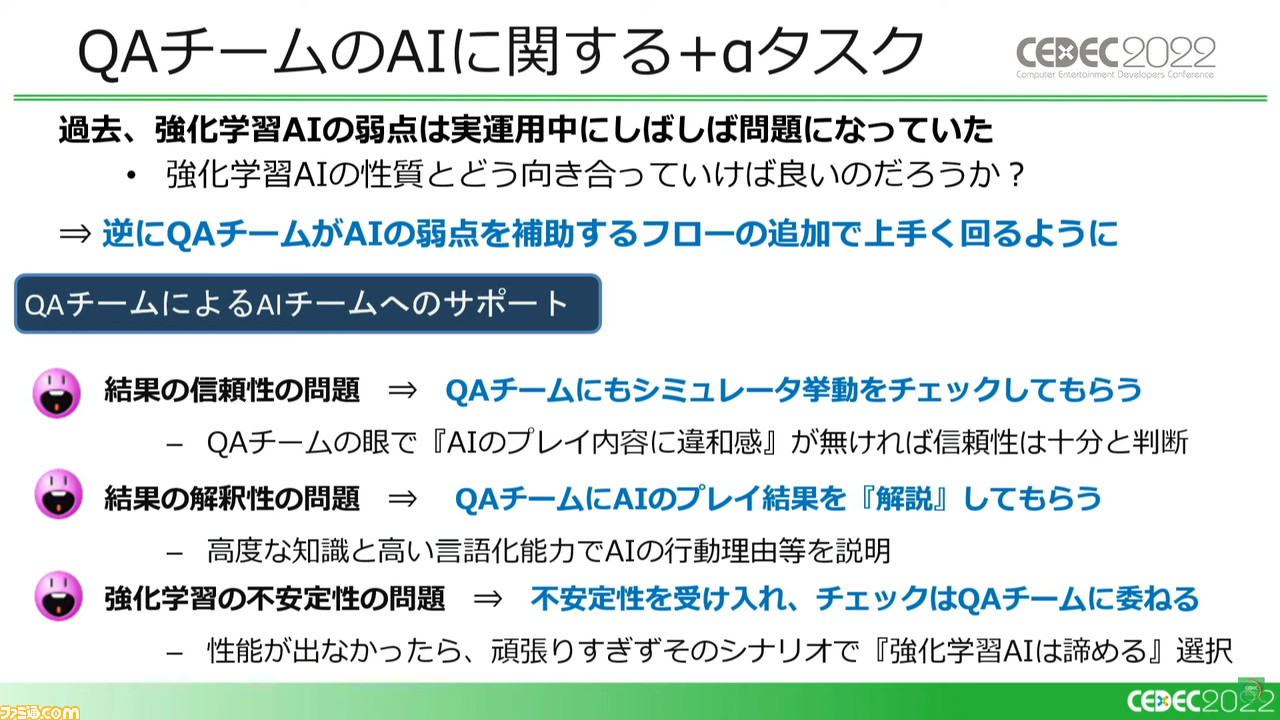

実際の運用中にこうした問題は浮き彫りになったが、逆にQAチーム側からのダブルチェックやプレイ結果の解説、不安定性を受け入れ担当を再考するなどといったサポートによって、これらの問題は解消できた。

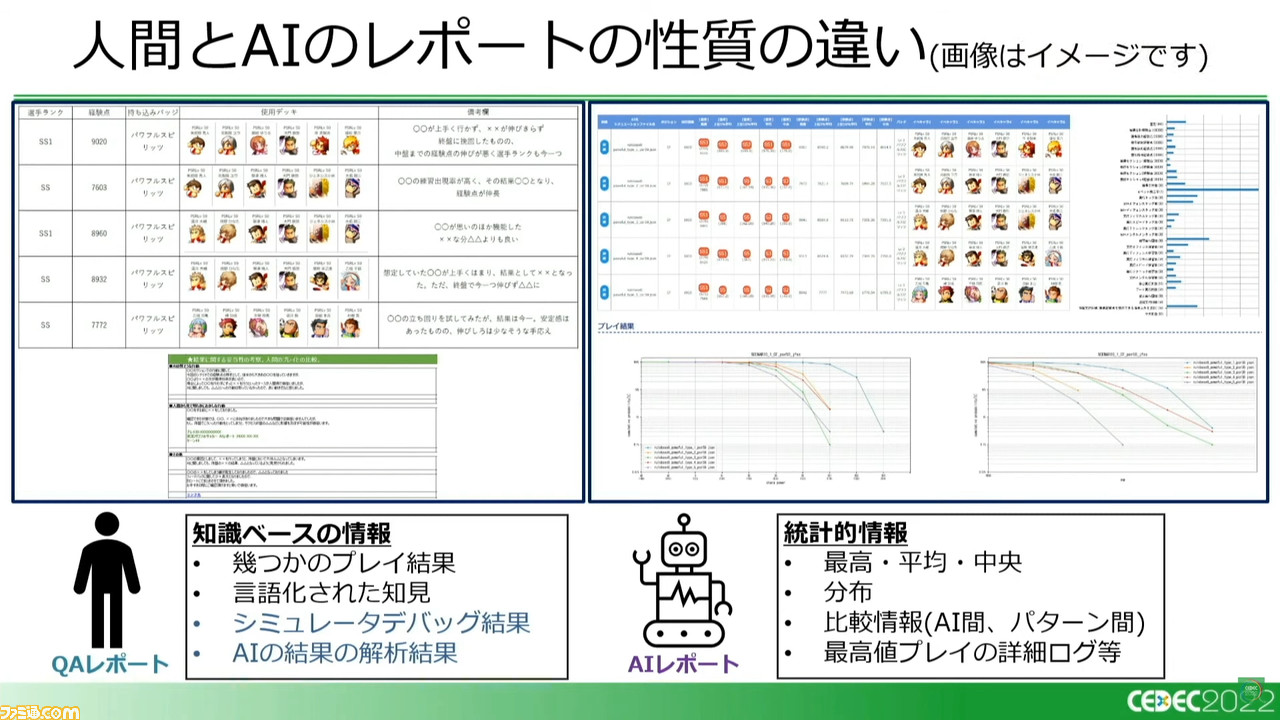

このように『パワサカ』運営においては、AIと人間の関係性が“相互協力”の形になったことにより、フローがより円滑に回るようになっている。知識ベースのQA(人間)による高い言語化能力と、統計ベースのAIによる幅広い比較データが、お互いを支え合っているわけだ。

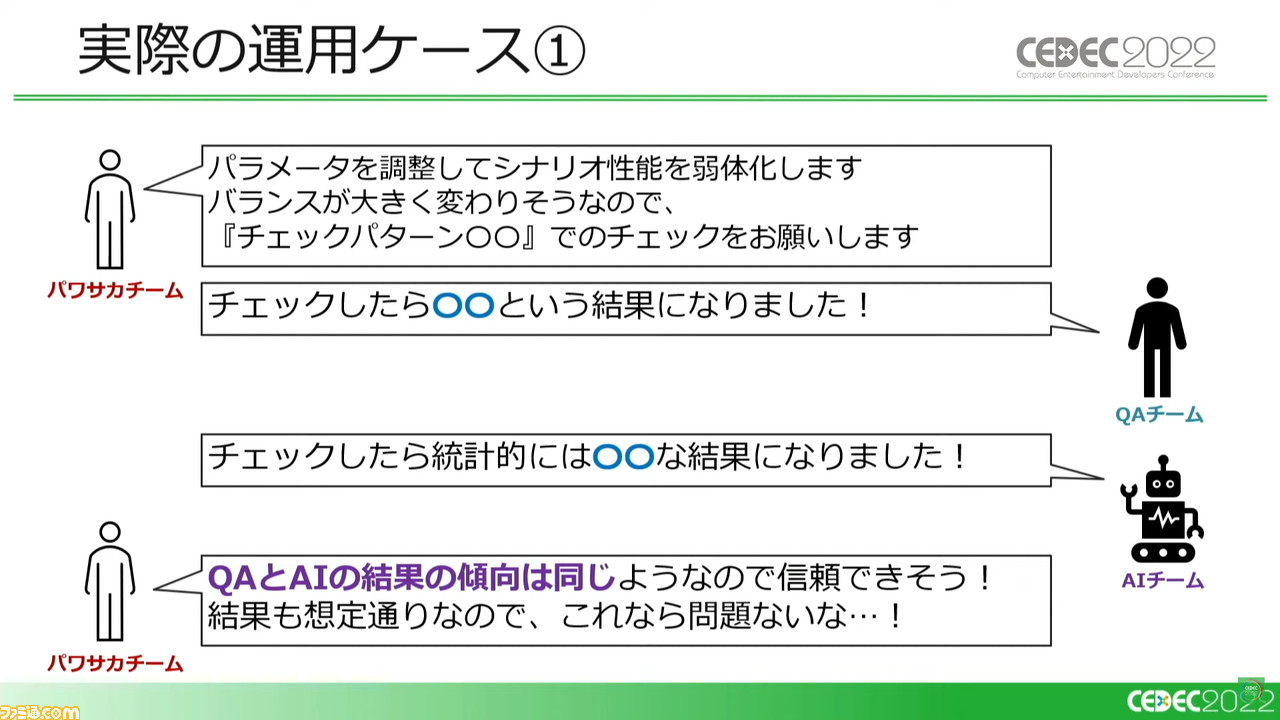

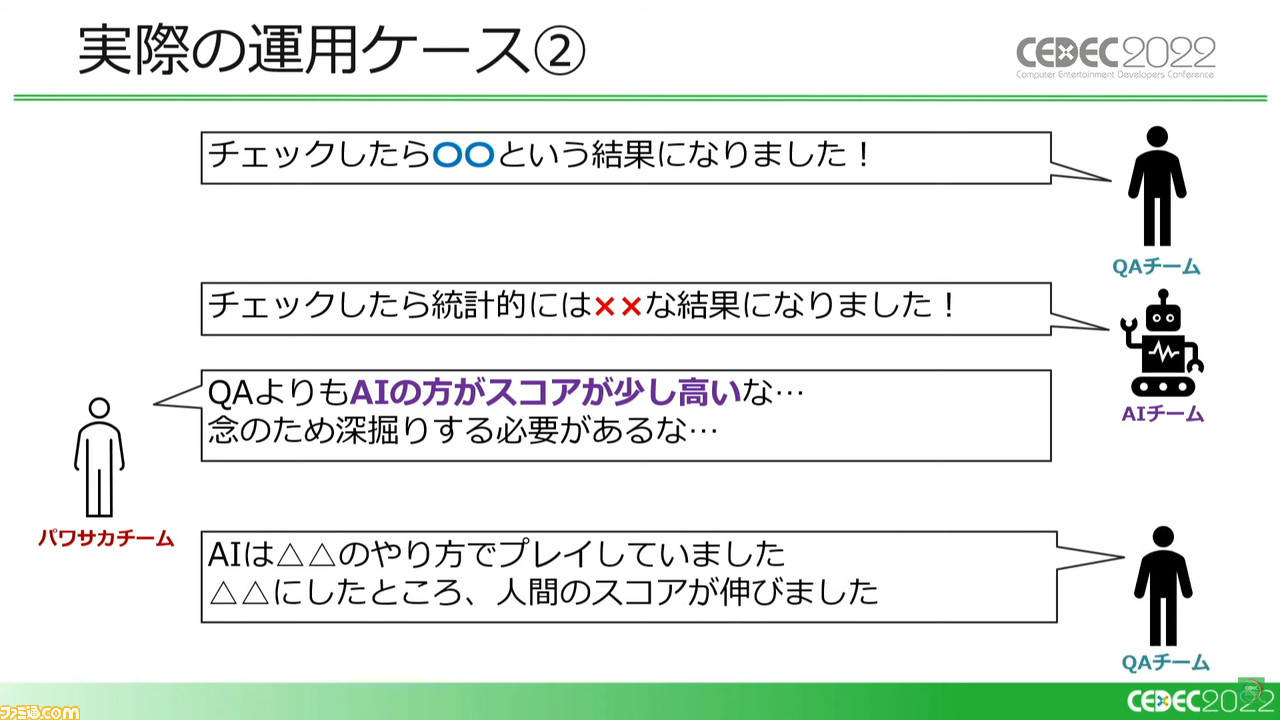

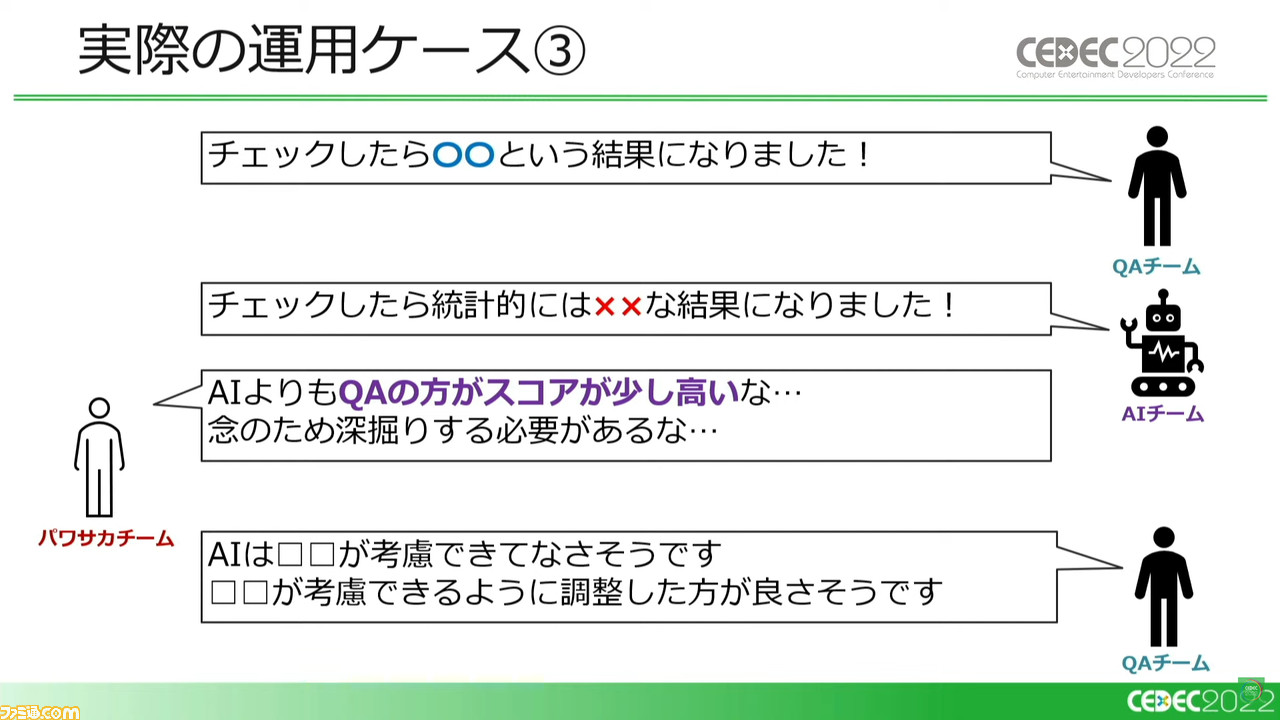

講演内では、実際にあった運用ケースも紹介された。いずれのパターンでも、QA(人間)とAIがそれぞれチェックしあうことでさまざまなメリットが生まれ、事故的な問題の事前回避も実現している。

AIの導入によりQAテスターのカバーしづらい部分がフォローされ、想定外の事態の減少に加え、チェックの円滑化・高速化や短期間での統計に基づく調整の実現など、長い試行錯誤と運用の結果、テスト環境はより良い方向に進歩し続けている。

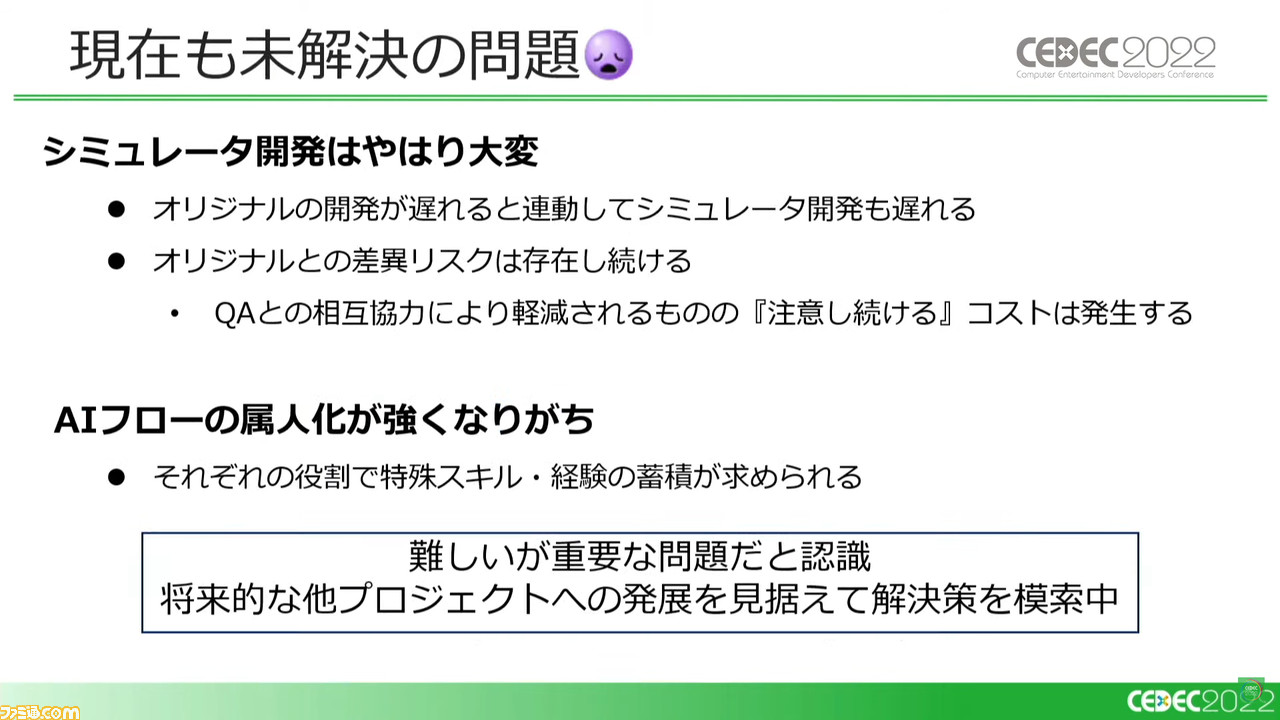

ただ、変わらない問題として、シミュレーター開発がオリジナル開発の遅延などの影響をもろに受ける部分や、どうしてもフロー内で各員の専門的な知識や経験に頼るところが大きく、急な担当変更などには対応が難しいといった部分などがいまだ存在しているという。

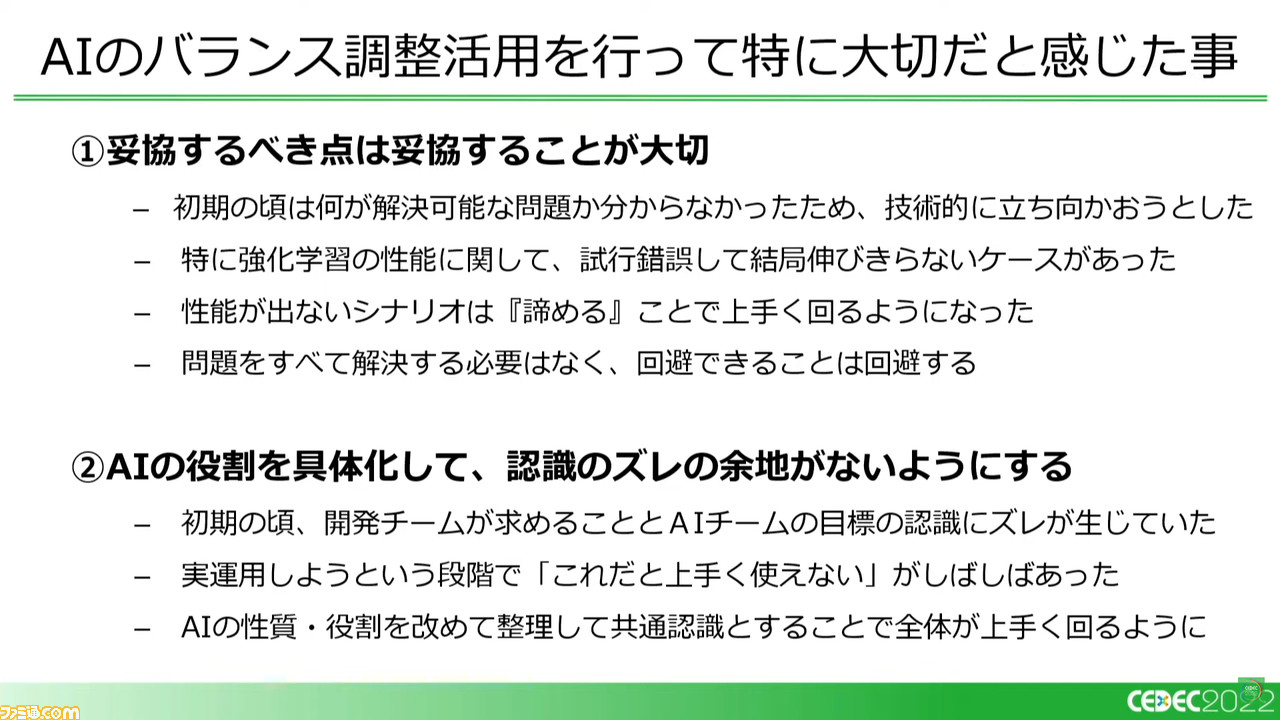

『パワサカ』のバランス調整に対するAI活用で、担当者がとくに大切だと思われた部分についても発表で共有された。技術的にやみくもに立ち向かうのではなく“妥協点”をうまく見いだすこと、AIの役割を共通認識とすること、題材に対する相性を考慮すること、開発チームも含めた運用体制を最初期から構築すること。以上の4点だ。

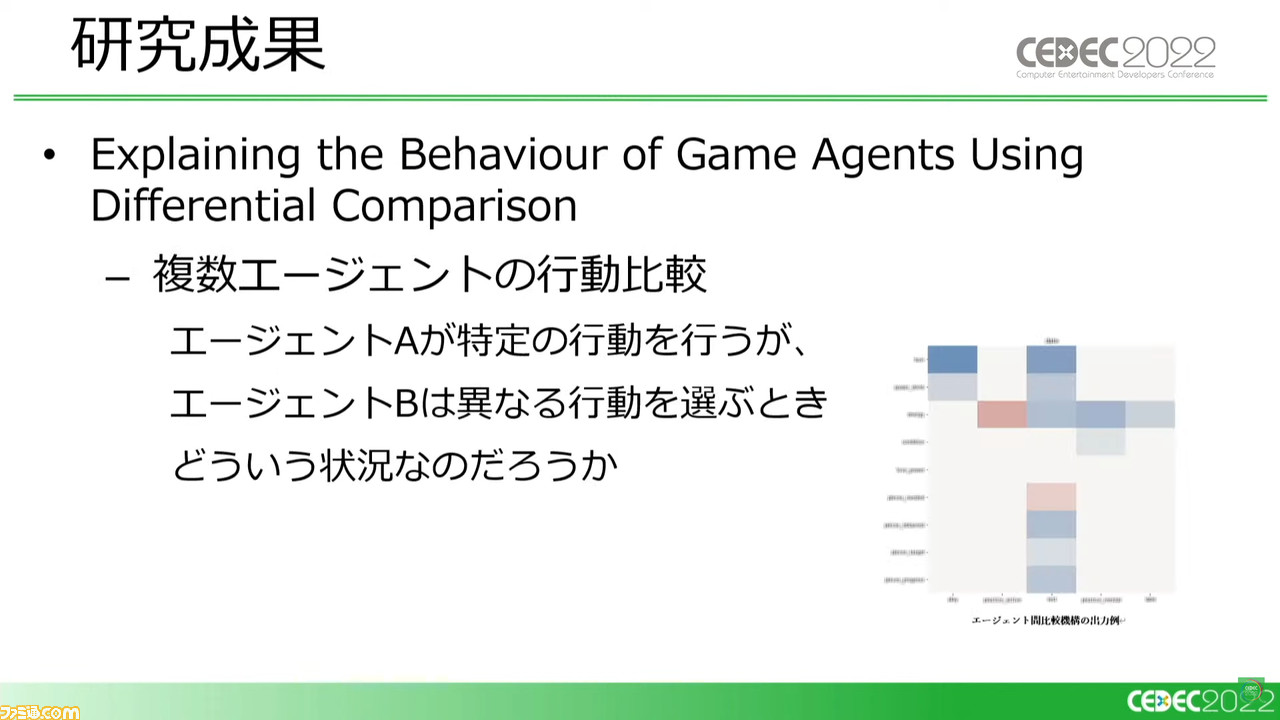

こうした強化学習運用については、さらにアカデミックな観点から国立情報学研究所のチームと共同研究がされたという。ふたつのAIの性能差がなぜ生まれるのか、その行動比較を題材とした論文が2022年10月に開催予定の“ASE4Games 2022”で発表されるとのことで、強化学習AI運用に興味を持ったならぜひ確認していただきたい。

強化学習AIは、いまや開発チームの大事な一員

講演の最後にはまとめとして、あくまで開発されたAIは万能ではなく、つねに最高のプレイをするというものではないという点に言及された。だからこそ、制作チームはAIの得手不得手を理解しつつ受け入れていったのだという。

印象的なエピソードとして、運営チームの人に「AIも経験を積んでゲームプレイがうまくなってきたね」と言われたことがあるという。実際には今回紹介したAIは記憶能力を持っておらず、毎日ゼロから学習しているため、経験が蓄積することはない。強化学習AIと一緒にいる人間のスタッフたちのほうがAIを理解し成長してきたことが、AIの成長と受け止められたのだろう。

AIへの過度な期待や結果への猜疑心など、いまなおAIを人間とは別次元の存在として受け止めている人も多いかとは思う。『桃鉄』と『パワサカ』の今回紹介された強化学習AIに関する具体的な事例は、そうしたAIとの関係を見直すだけでなく、より高度なAI運用に昇華できる大きなヒントとしてぜひ一考してみてほしい。